#spark中拼接RDD指定行数据,RDD合并成一行,python实现 from pyspark import SparkContext sc = SparkContext( local , My App ) rows = sc.parallelize([[1, 2, 3], [4, 5, 6], [7, 8, 9

第7课:实战解析spark运行原理和RDD解密 - Ha

1193x762 - 428KB - PNG

Apache Spark : RDD - 暝月

446x300 - 42KB - PNG

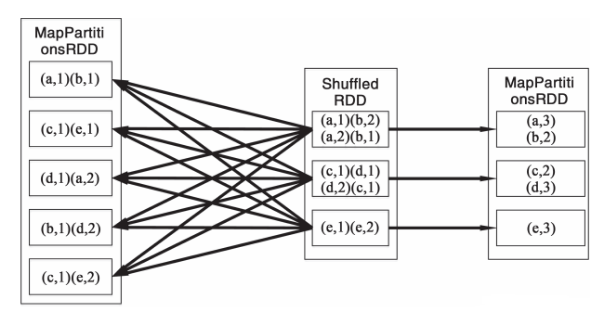

大数据Spark04RDD宽窄依赖 - yangshaojun19

576x404 - 170KB - PNG

Spark RDD概念学习系列之RDD的操作(七) - 大

609x316 - 70KB - PNG

【Spark】弹性分布式数据集RDD概述_「电脑

390x254 - 36KB - JPEG

Spark RDD详解 - 其他综合 - 红黑联盟

550x254 - 13KB - JPEG

Apache Spark 2.2.0 中文文档 - Spark RDD(Re

856x472 - 108KB - PNG

Spark交通数据分析案例:大型活动大规模人群的

640x360 - 20KB - JPEG

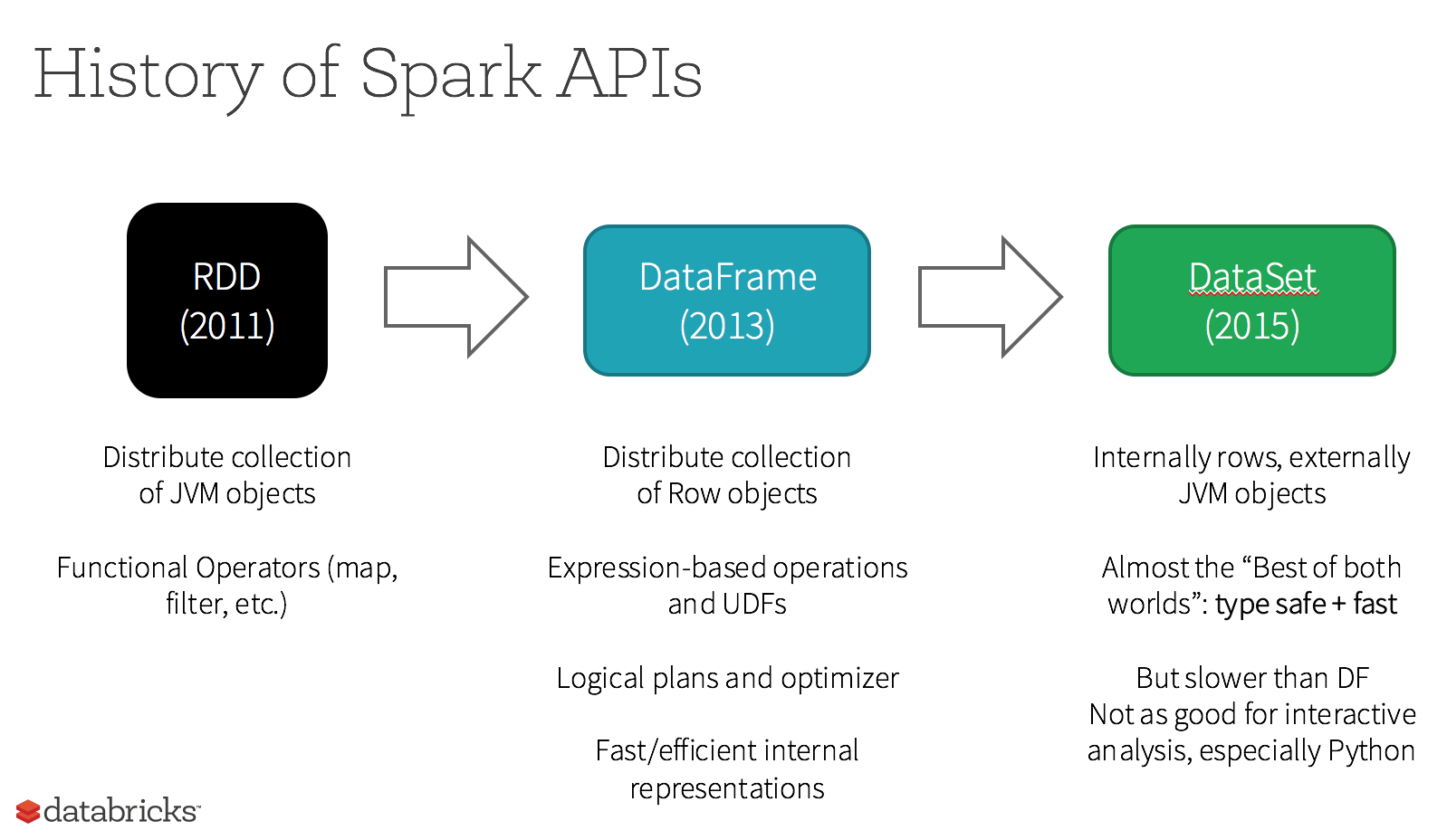

如何理解spark中RDD和DataFrame的结构? - 大

1598x928 - 91KB - PNG

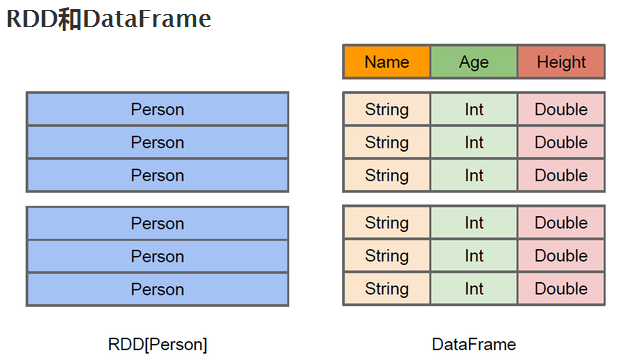

如何理解spark中RDD和DataFrame的结构? - 大

617x362 - 67KB - PNG

Spark的RDD原理以及2.0特性的介绍_「电脑玩

640x443 - 115KB - JPEG

Spark RDD概念学习系列之Spark的数据存储(十

810x479 - 95KB - PNG

深入浅出Spark(二) 什么是RDD - 论码农的自我

895x386 - 229KB - PNG

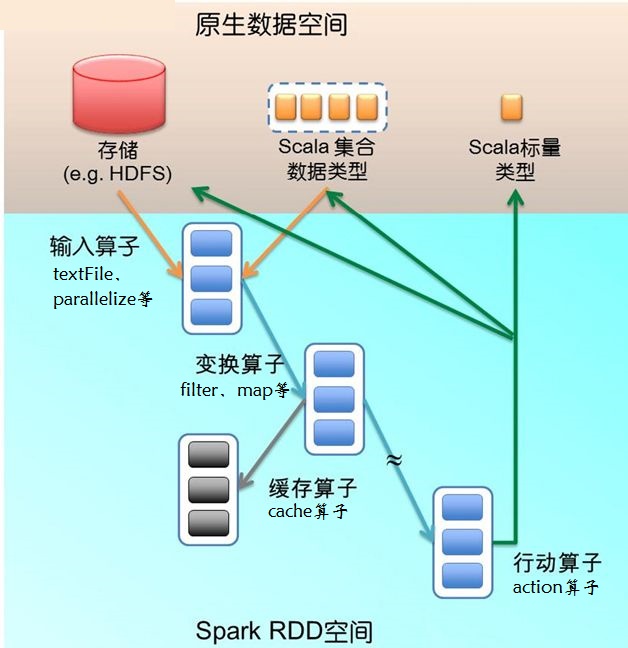

spark RDD 算子运行过程及分类 - 张欢19933的

628x648 - 82KB - JPEG

大数据之谜Spark基础篇,核心RDD特征分析讲

600x425 - 310KB - JPEG