588x410 - 118KB - PNG

【深度学习 练习】 - CSDN

【深度学习 练习】 - CSDN

472x334 - 87KB - PNG

卷积核大小的影响

卷积核大小的影响

873x300 - 66KB - JPEG

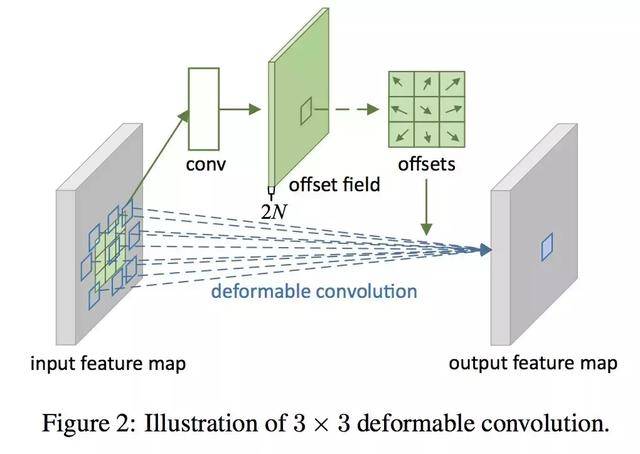

「模型解读」卷积核可以随意变化的CNN

「模型解读」卷积核可以随意变化的CNN

640x454 - 27KB - JPEG

卷积核

卷积核

1386x642 - 222KB - JPEG

卷积核定义

卷积核定义

500x379 - 16KB - JPEG

卷积核定义

卷积核定义

500x375 - 27KB - JPEG

卷积核大小的影响

卷积核大小的影响

516x300 - 23KB - JPEG

卷积核定义

卷积核定义

518x300 - 17KB - JPEG

卷积核调整实验报告

卷积核调整实验报告

545x200 - 54KB - PNG

干货|用反卷积网络合成超逼真人脸:理解

干货|用反卷积网络合成超逼真人脸:理解

640x436 - 27KB - JPEG

卷积核

卷积核

842x428 - 26KB - JPEG

多通道的多个卷积核

多通道的多个卷积核

600x260 - 58KB - PNG

卷积核调整实验报告

卷积核调整实验报告

489x241 - 45KB - PNG

关于深度学习中卷积核操作

关于深度学习中卷积核操作

519x514 - 11KB - PNG

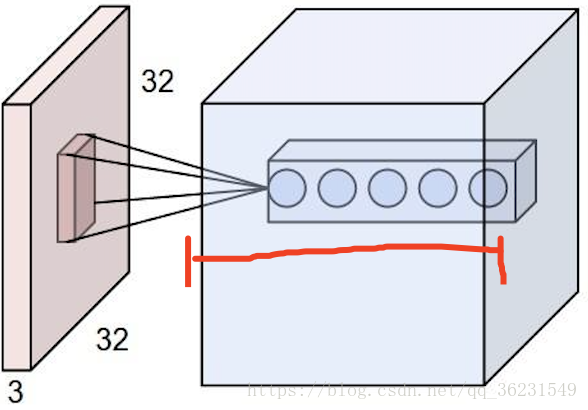

简介:卷积核就是图像处理时,给定输入图像,输入图像中一个小区域中像素>加权平均后成为输出图像中的每个对应像

4、一个卷基层有多少个参数:一个卷积核使用一套权值以便”扫视’数据每一处时以同样的方式抽取特征,最终得到的是一种特征。在tensorflow定义conv2d时需要指定卷积核的

接下来对图像做卷积操作,也就是调用Convolution中的valide方法。注意这里使用的是valide,因此不需要处理边缘,处理后的图像比原图像减小卷积核大小-1。 import java.io.File;

[最佳答案] 一般都是定了一个固定的核的,例如你29*29的图片,就用5*5的核。 这些都是经验。 当然你也可以用大些的。 然后核的具体的值,就是要训练出来的, 核的初始化的话,若果你的输入是0-1之前,那么核值也可以初始化在0-1之间,不会有太大的误差。 《神经网络之家》专讲神经网络这一块

为了比较3*3卷积核和5*5卷积核在性能上到底有多大区别设计了两个网络去进行对比,1.两个3*3的卷积核,2个池化层,2个全连接层2.两个5*5的卷积核,2个池化层,2个全连接层两

[最佳答案] 卷积是图像处理常用的方法,给定输入图像,在输出图像中每一个像素是输入图像中一个小区域中像素的加权平均,其中权值由一个函数定义,这个函数称为卷积核, 比如说卷积公式:R(u,v)=∑∑G(u-i,v-j)f(i,j) ,其中f为输入,G为卷积核。

卷积核(convolutional kernel):可以看作对某个局部的加权求和;它是对应局部感知,它的原理是在观察某个物体时我们既不能观察每个像素也不能一次观察整体,而是先从局部开始

然后,CNN中的卷积核的一个重要特点是它是需要网络自己来学习的。这一点很简单也很重要:一般的卷积核如sobel算子、平滑算子等,都是人们根据数学知识得到的,比如求导,平

同样需要明确一个概念:比如某层的卷积核参数为3*3*64,表示卷积核的尺寸为3*3的,卷积核的个数是64个,这也就意味着经过该层卷积后的图像通道是64,那么参数的数量是不是