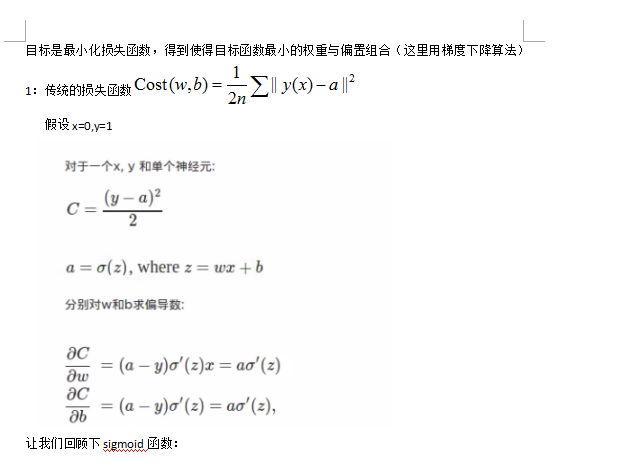

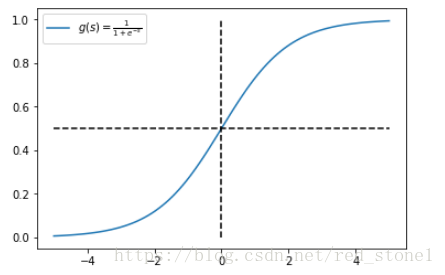

因此引入了交叉熵代价函数克服此问题。但是由于近年来ReLU的兴起,很少有人再用sigmoid作为激活函数。然而仍有同学向我推荐使用交叉熵损失函数,在使用ReLU的前提下

为什么逻辑回归中要使用交叉熵损失函数? - 今

613x480 - 75KB - JPEG

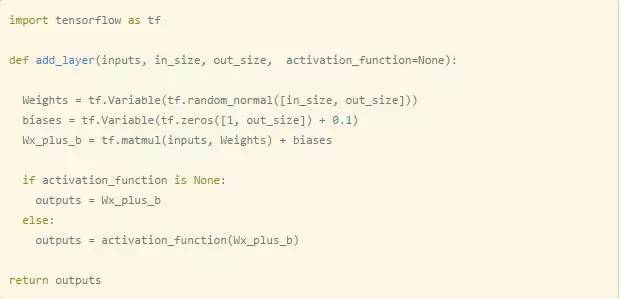

深度学习笔记:交叉熵(cross-entropy)损失函数解

551x290 - 14KB - PNG

人工智能里的数学修炼 之 交叉熵损失函数:从信

1282x682 - 46KB - PNG

为什么逻辑回归中要使用交叉熵损失函数? - 今

393x439 - 18KB - JPEG

为什么逻辑回归中要使用交叉熵损失函数? - 今

619x261 - 39KB - JPEG

s entropy-前馈神经网络 误差\/交叉熵损失函数\/c

600x288 - 13KB - JPEG

理解交叉熵作为损失函数在神经网络中的作用_

1416x504 - 79KB - JPEG

简单易懂的softmax交叉熵损失函数求导

1018x755 - 110KB - PNG

通俗理解简单的交叉熵损失函数

586x462 - 60KB - PNG

nerualnetworkanddeeplearning学习_交叉熵损失函数

421x282 - 12KB - PNG

交叉熵损失函数

628x468 - 51KB - PNG

简单易懂的softmax交叉熵损失函数求导

907x328 - 27KB - PNG

神经网络的交叉熵损失函数 - 程序园

1015x603 - 34KB - JPEG

1. 交叉熵损失函数的数学原理

445x275 - 21KB - PNG

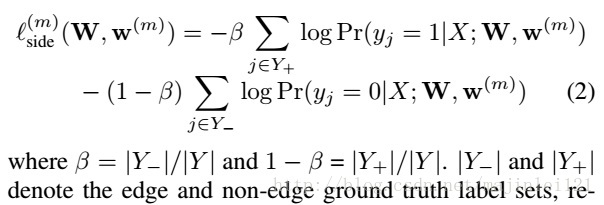

caffe 加权交叉熵损失函数层(weighted sigmoid

604x205 - 34KB - JPEG