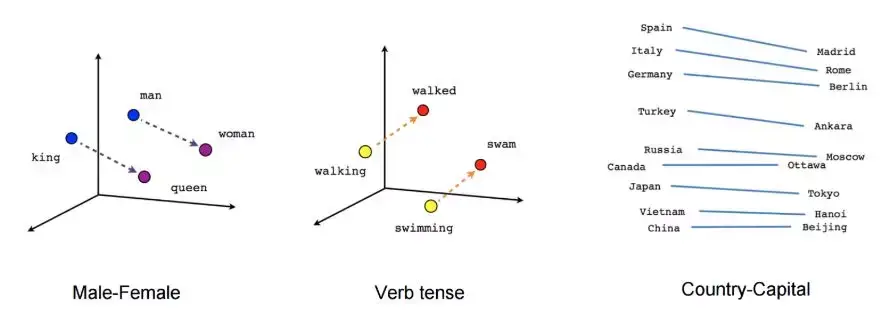

并且需猜测相邻位置的输入词,在word2vec中词袋模型假设下,词的顺序是不重要的。训练完成之后,word2vec模型可用来映射每个词到一个向量,可用来表示词对词之间的关系,该

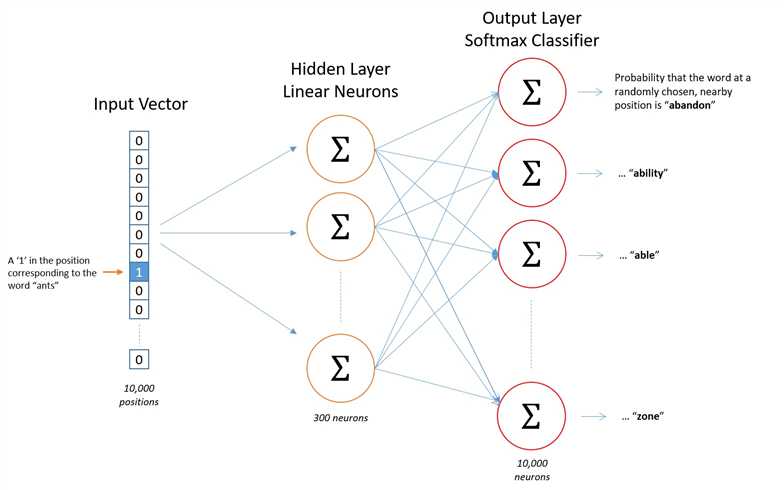

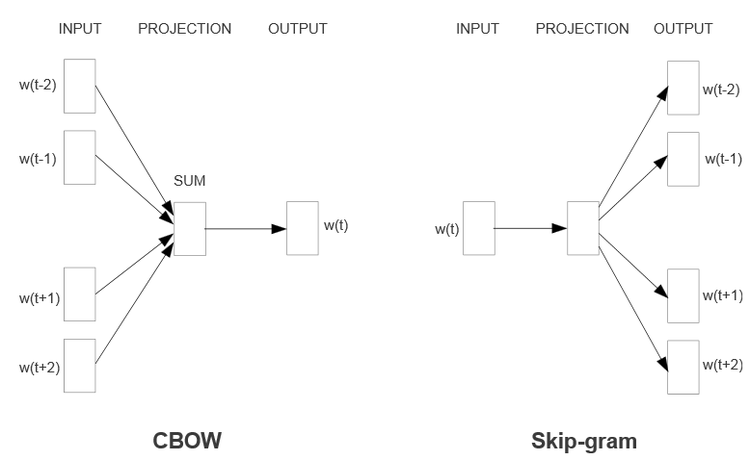

word2vec 模型思想和代码实现 不会停的蜗牛 0.3 2016.08.24 10:28* 字数 1154 CS224d-Day 3: word2vec 有两个模型,CBOW和 Skip-Gram,今天先讲 Skip-Gram的算法和实现

以上就是神经网络语言模型中如何用CBOW与Skip-Gram来训练模型与得到词向量的大概过程。但是这和word2vec中用CBOW与Skip-Gram来训练模型与得到词向量的过程有很

特征学习对于word2vec模型并不需要一个完全的概率模型。及对于相同的上下文,CBOW和 skip-gram模型训练使用二分类目标函数(binary classification objective)从 个假想(im

利用word2vec进行词向量进行训练时,所用语料进行分词有训练好的模型也可以,谢谢解答!您的回答被采纳后如何答题 获取采纳 使用财富值 玩法介绍 知道商城 知道

在word2vec原理(一) CBOW与Skip-Gram模型基础中,我们讲到了使用神经网络的方法来得到词向量语言模型的原理和一些问题,现在我们开始关注word2vec的语言模型如何改进

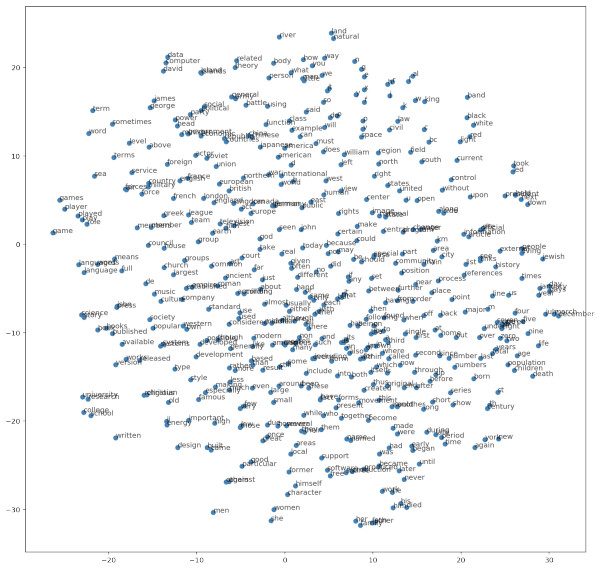

到机器学习模型中进行预测。本教程将对现在使用的主要技术,即「Word2Vec」进行介绍。在讨论了相关的背景材料之后,我们将使用 TensorFlow实

在Word2Vec模型中,默认sentences是可迭代类型。在中文自然语言处理中,常用分词降噪后的文本作为sentences输入,关于中文分词可以参考:j浅谈中文分词与jieba源码 上述代

word2vec利用了词的上下文,语义信息更加丰富。基于word2vec,出现了phrase2vec, se 本文沿用了word2vec的skip-gram模型,主要区别体现在特征

word2vec词向量训练及中文文本相似度计算 - 其

661x575 - 73KB - PNG

一文详解 Word2vec 之 Skip-Gram 模型(结构篇

600x363 - 17KB - JPEG

Word2Vec之Skip-Gram模型

1569x980 - 381KB - PNG

深度学习将会变革NLP中的中文分词

663x482 - 59KB - JPEG

深度学习利器:TensorFlow与NLP模型 -人工智能

750x460 - 38KB - PNG

技术干货 | 漫谈Word2vec之skip-gram模型

587x413 - 16KB - PNG

一文详解 Word2vec 之 Skip-Gram 模型(实现篇

600x569 - 94KB - JPEG

自然语言处理的一大步,应用Word2Vec模型学习

640x545 - 111KB - JPEG

利用摇滚乐队学习TensorFlow,Word2Vec模型和

936x648 - 81KB - JPEG

NLP中word2vec的CBOW模型和Skip-Gram模型

671x407 - 94KB - PNG

自然语言处理一大步,应用Word2Vec模型学习单

881x321 - 34KB - JPEG

自然语言处理的一大步,应用Word2Vec模型学习

640x233 - 13KB - JPEG

一文详解 Word2vec 之 Skip-Gram 模型(训练篇

600x325 - 22KB - JPEG

word2vec学习+使用介绍_「电脑玩物」中文网

423x248 - 8KB - JPEG

三、word2vec模型的训练

640x796 - 49KB - JPEG