内容参考:Tensorflow四种交叉熵函数计算公式:tf.nn.cross_entropyTensorFlow四种Cross Entropy算法实现和应用交叉熵(Cross Entropy)交叉熵(Cross Entropy)是Loss函数的一种

简介:语言模型的性能通常用交叉熵和复杂度(perplexity)来衡量。交叉熵的意义是用该模型对文本识别的难度,或者从

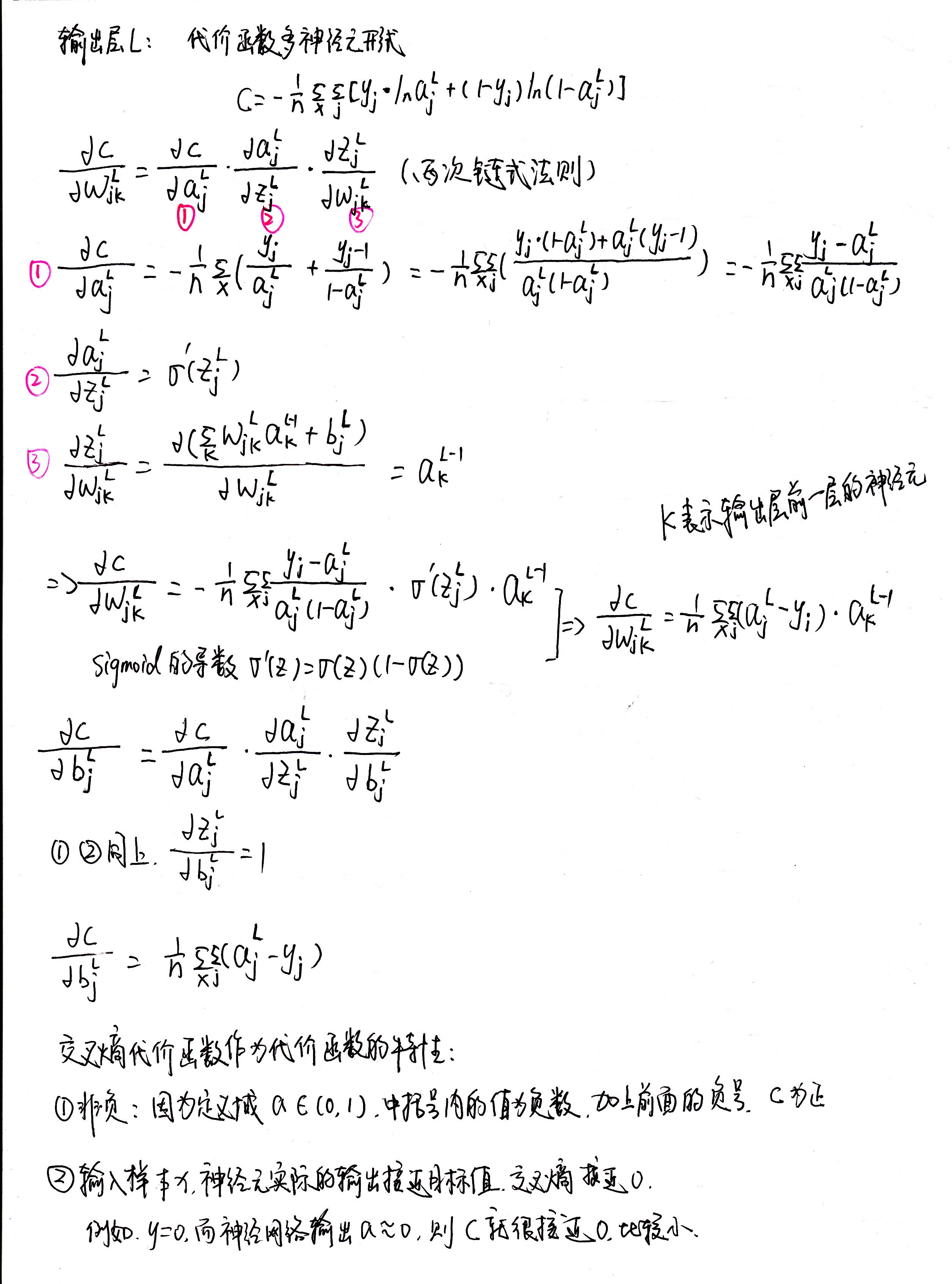

交叉熵代价函数(Cross-entropy cost function)是用来衡量人工神经网络(ANN)的预测值与实际值的一种方式。与二次代价函数相比,它能更有效地促进ANN的训练。在介绍交叉熵

交叉熵代价函数(Cross-entropy cost function)是用来衡量人工神经网络(ANN)的预测值与实际值的一种方式。与二次代价函数相比,它能更有效地促进ANN的训练。在介绍交叉熵

交叉熵代价函数(Cross-entropy cost function)是用来衡量人工神经网络(ANN)的预测值与实际值的一种方式。与二次代价函数相比,它能更有效地促进ANN的训练。在介绍交叉熵

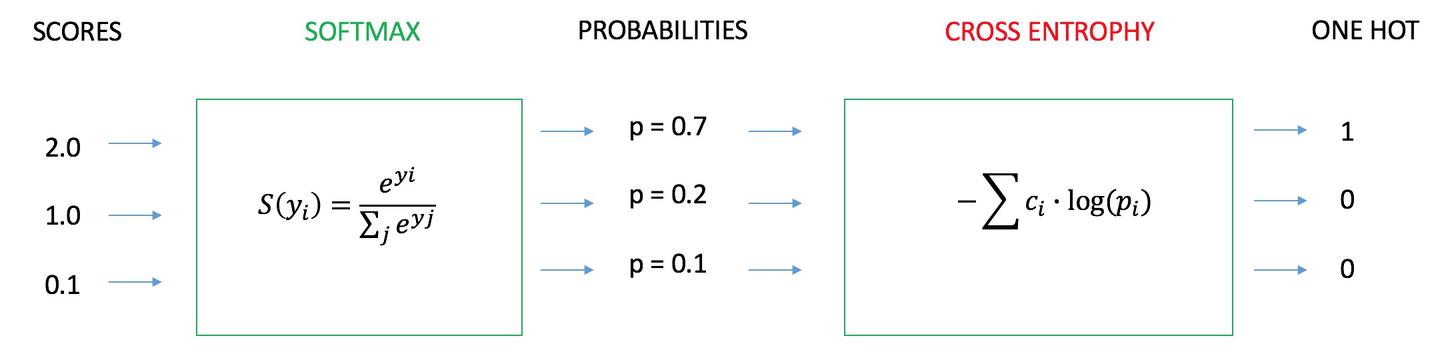

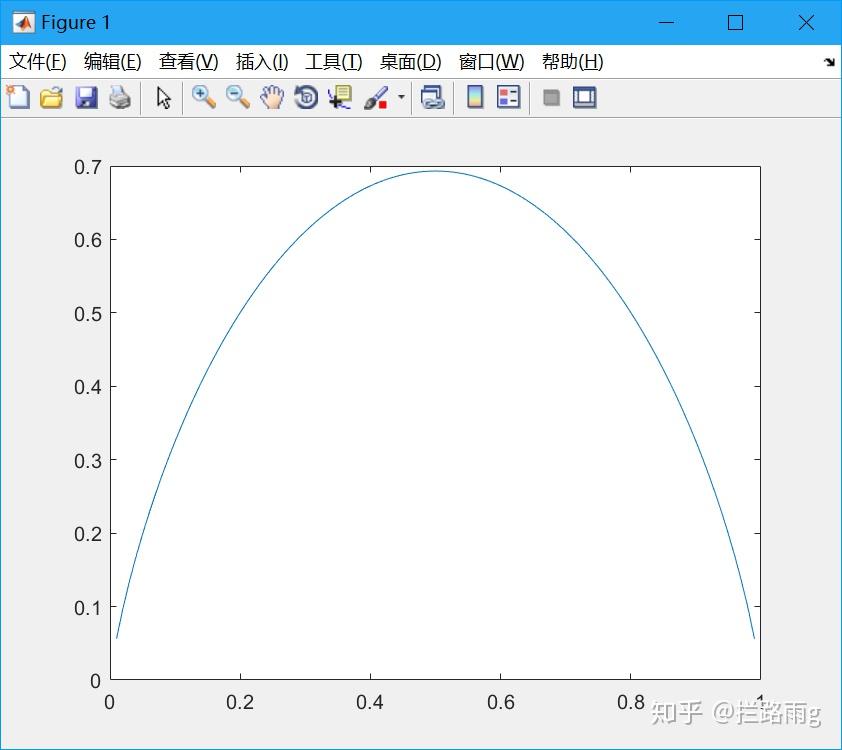

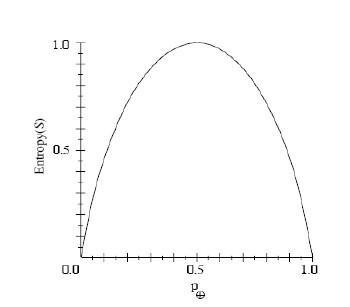

作为一个损失函数假设p为所期望的输出和概率分布( 编码 ),其中实际值有100%,而其他 有这样一个定理:当p=q时,交叉熵去的最小值.因此可以利用交叉熵比较一个分布与另一个

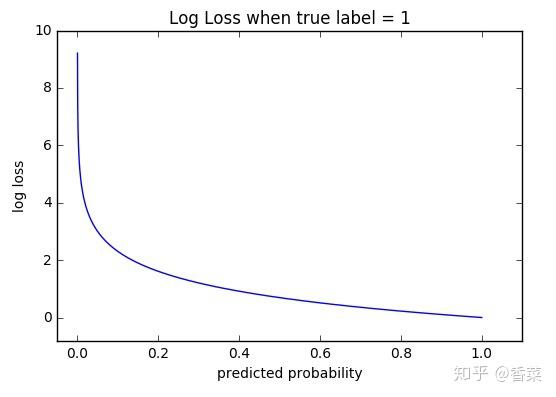

交叉熵可在神经网络(机器学习)中作为损失函数,p表示真实标记的分布,q则为训练后的模型的预测标记分布,交叉熵损失函数可以衡量p与q的相似性。交叉熵作为损失函数还有一

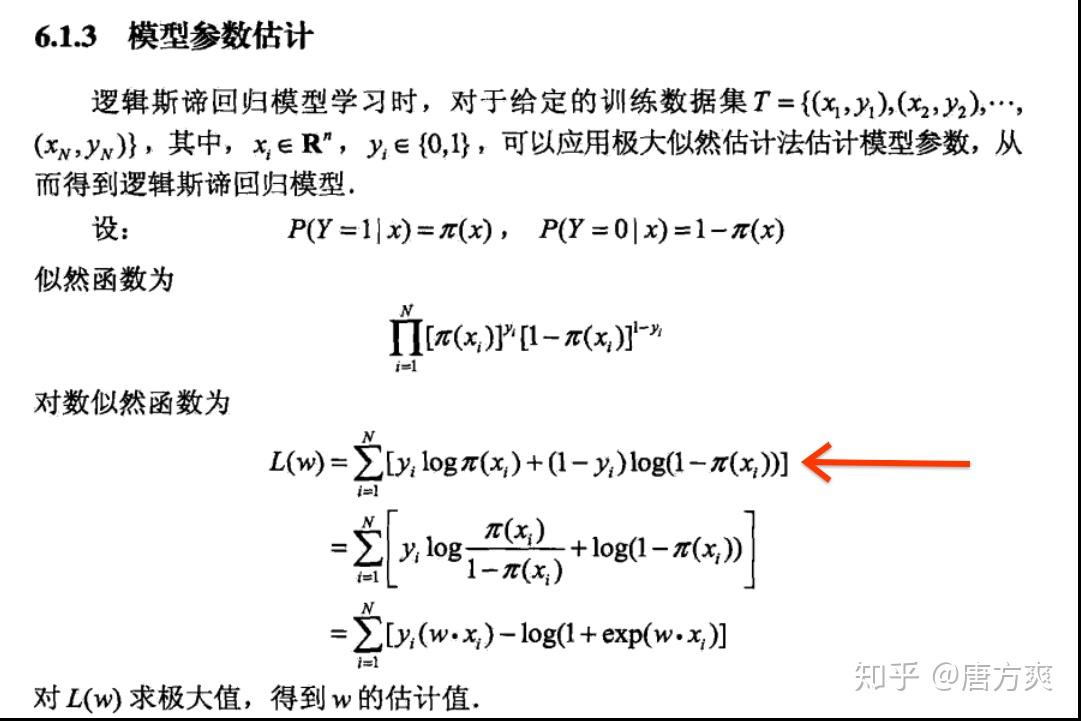

那么我们不妨领代价函数为上述组合对数概率的相反数: J(θ)=−1m∑i=1my(i)log(hθ(x(i)))+(1−y(i))log(1−hθ(x(i))) 上式即为大名鼎鼎的交叉熵损失函数。(说明:如果熟悉

函数作为神经元的激活函数时,最好使用交叉熵代价函数来替 代方差代价函数,以避免训练过程太慢。 不过,你也许会问,为什么是交叉熵函数?导数中不带 σ′(z) 项的函数有无数

另外,交叉熵函数的形式是−[ylna+(1−y)ln(1−a)]而不是 −[alny+(1−a)ln(1−y)],为什么?因为当期望输出的y=0时,lny没有意义;当期望y=1时,ln(1-y)没有意义。而因为a是sigmoid函

简单易懂的softmax交叉熵损失函数求导

640x231 - 8KB - JPEG

关于神经网络中的代价函数交叉熵的由来

611x211 - 25KB - PNG

【读懂深度学习中的代价函数、交叉熵】- 一点

469x501 - 33KB - JPEG

为什么逻辑回归的损失函数叫做交叉熵呢?

1081x721 - 121KB - JPEG

交叉熵代价函数

2512x3388 - 1418KB - JPEG

损失函数--交叉熵损失函数

1200x500 - 48KB - JPEG

交叉熵损失函数

678x260 - 47KB - PNG

交叉熵损失函数

588x260 - 29KB - PNG

简单易懂的softmax交叉熵损失函数求导

640x475 - 29KB - JPEG

交叉熵代价函数(作用及公式推导)

497x302 - 33KB - PNG

损失函数--交叉熵损失函数

556x397 - 22KB - JPEG

交叉熵作为分类任务的损失函数,去掉log是否可

842x750 - 69KB - JPEG

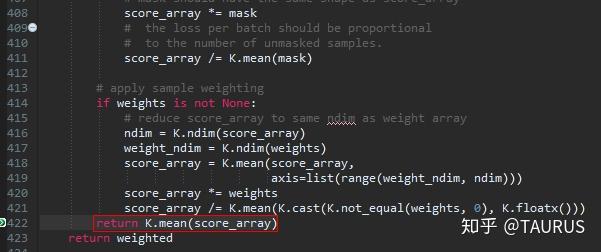

keras中两种交叉熵损失函数的探讨

350x307 - 6KB - JPEG

keras中两种交叉熵损失函数的探讨

601x252 - 48KB - JPEG

读懂深度学习中的代价函数、交叉熵

600x800 - 101KB - JPEG