损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵的函数是这样的: 其中y_i表

可能会有读者说,我已经知道了交叉熵损失函数的推导过程。但是能不能从更直观的角度去理解这个表达式呢?而不是仅仅记住这个公式。好问题!接下来,我们从图形的角度,分析

在Quora Question Pairs比赛中,我们的目标是判断给定的两个问题的语义信息是否相同(即是否为重复问题),使用的评估标准是log loss,交叉熵损失函数 \[ \frac{1}{N}\sum_{i=0}^{N

简介:语言模型的性能通常用交叉熵和复杂度(perplexity)来衡量。交叉熵的意义是用该模型对文本识别的难度,或者从

请. 1.前言在机器学习中学习模型的参数是通过不断损失函数的值来实现的。对于机器学习中常见的损失函数有:平方损失函数与交叉熵损失函数。在本文中将讲述两者含义与响

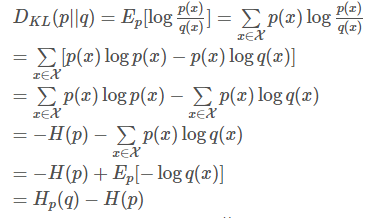

交叉熵损失函数 熵的本质是香浓信息量\(\log(\frac{1}{p})\)的期望 既然熵的本质是香浓信息量\(\log(\frac{1}{p})\)的期望,那么便有 \[ H(p)=E[p_i\times\log(\frac{1}{p_i})]=\sum p_i\tim

交 叉 熵 损 失 函 数 chyang1999|2018-06-30 (高于99%的文档) 马上扫一扫 手机打开 随时查看 手机打开 专业文档 专业文档是百度文库认证用户/机构上传的专业性文档,文库V

交叉熵就不是为了解决梯度消失的……他只是分类问题中极大似然估计自然导出的一个损失函数而已。用sigmoid在交叉熵之前只是为了构造一个 (0,1) 区间内的数用来表示一个概率。这种做法就只是logistics回归的形式到了神经网络里面的利用而已。

损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵的函数是这样的: C = -\sum

交叉熵可在神经网络(机器学习)中作为损失函数,p表示真实标记的分布,q则为训练后的模型的预测标记分布,交叉熵损失函数可以衡量p与q的相似性。交叉熵作为损失函数还有一

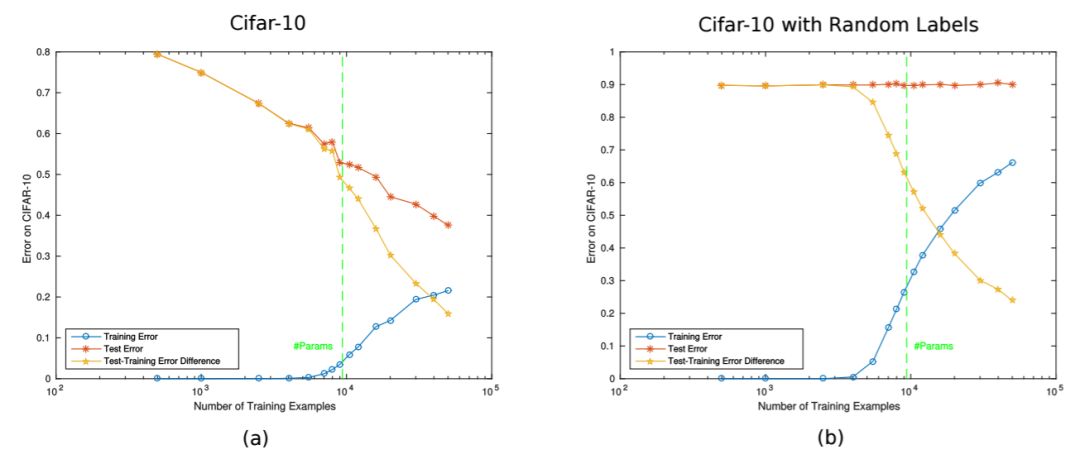

学界 | Tomaso Poggio深度学习理论:深度网络「

1080x464 - 36KB - JPEG

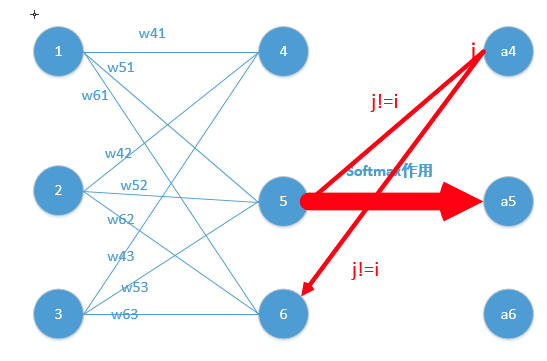

简单易懂的softmax交叉熵损失函数求导

640x231 - 8KB - JPEG

简单易懂的softmax交叉熵损失函数求导

640x475 - 29KB - JPEG

多伦多大学联手Uber推出RevNet,不用存储激活

640x240 - 23KB - JPEG

Softmax 函数的特点和作用是什么?

547x361 - 43KB - PNG

自测 斯坦福深度学习课程第四弹:作业与解答

430x241 - 17KB - JPEG

交叉熵损失函数 - 蓝讯

280x220 - 4KB - PNG

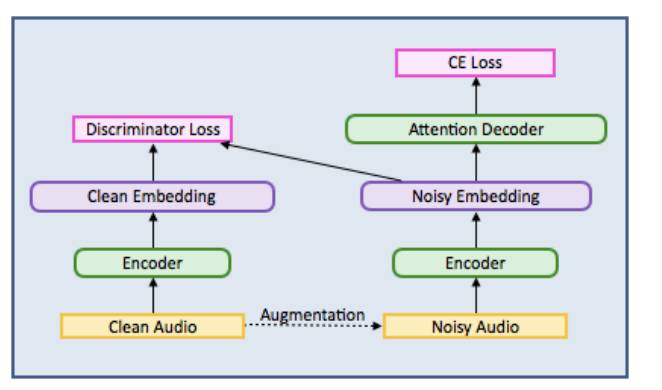

学界 | 百度提出使用GAN构建语音识别新框架

662x390 - 20KB - JPEG

交叉熵损失函数 - 蓝讯

280x220 - 5KB - PNG

交叉熵损失函数 - 蓝讯

280x220 - 34KB - PNG

机器学习最常用的损失函数之交叉熵

369x218 - 29KB - PNG

简单易懂的softmax交叉熵损失函数求导

640x475 - 47KB - JPEG

最前沿:围棋之后,AI玩FPS游戏也能秀人类一脸

1030x366 - 104KB - PNG

Deep Learning(1-Applying) - 今日头条(www.tou

640x234 - 17KB - JPEG

深度学习与自然语言处理(4)_斯坦福cs224d大作

430x242 - 38KB - PNG