熵相对熵考察两个信息(分布)之间的不相似性:所谓相对,自然在两个随机变量之间。又称互熵,Kullback–Leibler divergence(K-L散度)等。设p. 下载App 交叉熵相对熵(KL散度/互

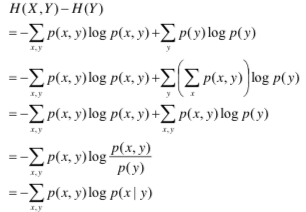

请听题:什么是熵?什么是交叉熵?什么是联合熵?什么是条件熵?什么是相对熵?它们的联系与区别是什么?如果你感到回答这些问题有些吃力,对这些概念似乎清楚,似乎又没有那

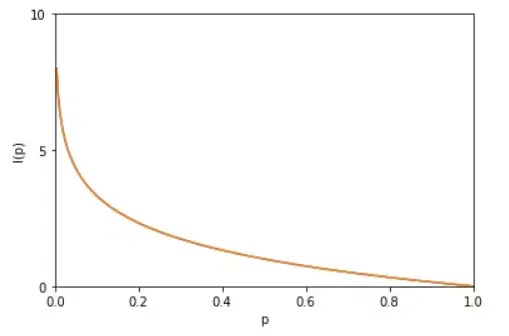

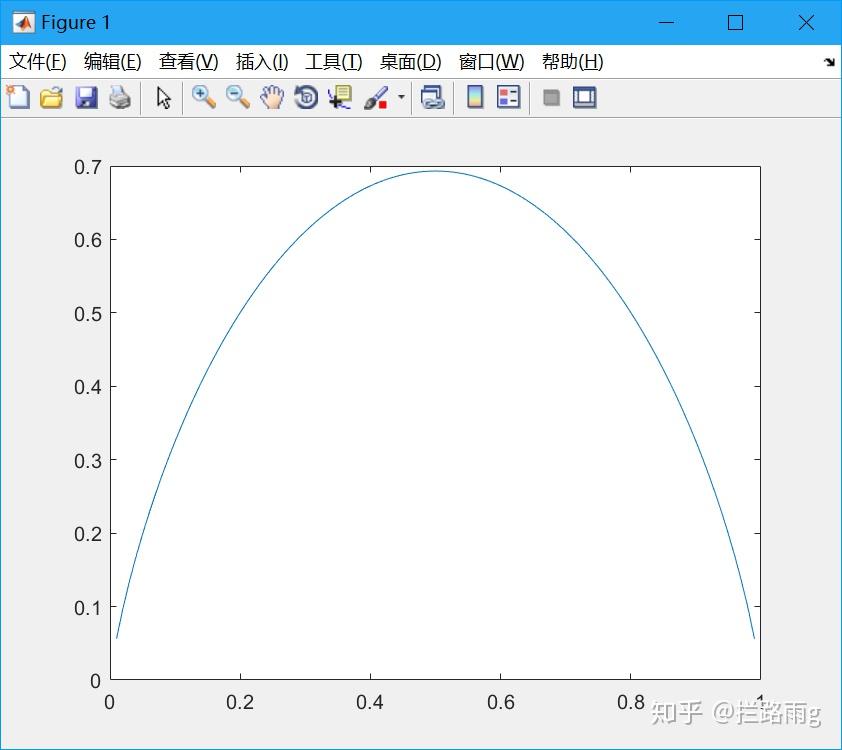

我们接下来要讨论的信息熵 交叉熵 相对熵 更多的着眼于信息论的角度,换句话说,更加关注概率和不确定性。 什么是信息熵、交叉熵、相对熵 可以将对熵的理解从简单到复杂

机器学习中,我们用非真实分布q去预测真实分布p,因为真实分布p是固定的,D(p||q) = H(p,q) - H(p)中 H(p)固定,也就是说交叉熵H(p,q)越大,相对熵D(p||q)越大,两个分布的差异越大

3、相对熵 (Relative entropy),也称KL散度 (Kullback–Leibler divergence) 设 $p(x)$、$q(x)$是离散随机变量 $X$中取值的两个概率分布,则 $p$对 $q$的相对熵是: $D_{KL}(p||q)

比如TD-IDF算法就可以理解为相对熵的应用:词频在整个语料库的分布与词频在具体文档中分布之间的差异性。 交叉熵可在神经网络(机器学习)中作为损失函数,p表示真实标记

我们接下来要讨论的信息熵 交叉熵 相对熵 更多的着眼于信息论的角度,换句话说,更加关注概率和不确定性 什么是信息熵、交叉熵、相对熵 可以将对

我们接下来要讨论的信息熵交叉熵相对熵更多的着眼于信息论的角度,换句话说,更加关注概率和不确定性。 什么是信息熵、交叉熵、相对熵 可以将对

机器学习中,我们用非真实分布q去预测真实分布p,因为真实分布p是固定的,D(p||q) = H(p,q) - H(p)中 H(p)固定,也就是说交叉熵H(p,q)越大,相对熵D(p||q)越大,两个分布的差异越大

交叉熵和相对熵(KL散度)? 为什么梯度相反的方向是函数下降最快的方向? 求SIFT算子的步骤和优化方法? 一个链表,依次输出第一个,倒数第一个,第

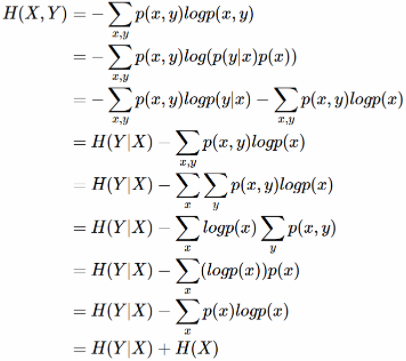

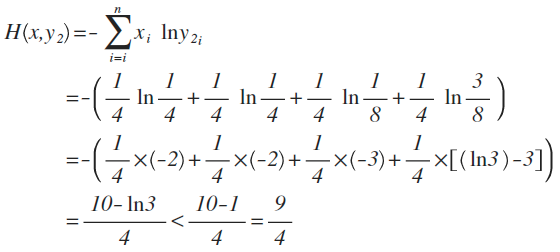

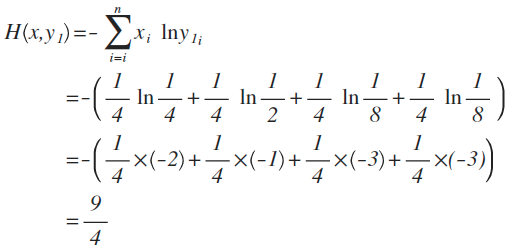

详解机器学习中的熵、条件熵、相对熵和交叉熵

406x361 - 39KB - JPEG

详解机器学习中的熵、条件熵、相对熵、交叉熵

316x273 - 14KB - JPEG

廖先桃.最大熵理论及其应用.pdf

800x600 - 36KB - PNG

归一化(softmax)、信息熵、交叉熵

560x252 - 26KB - PNG

归一化(softmax)、信息熵、交叉熵

512x252 - 23KB - PNG

熵,条件熵,互信息,交叉熵 的理解总结

500x478 - 71KB - JPEG

详解机器学习中的熵、条件熵、相对熵和交叉熵

509x336 - 12KB - JPEG

熵,条件熵,互信息,交叉熵 的理解总结

306x212 - 18KB - JPEG

基于交叉熵的出租车资源合理配置.PDF

800x1131 - 278KB - PNG

基于交叉熵的病毒式移动通信系统性能研究-控

800x1131 - 71KB - PNG

![[原]最大熵模型中的数学推导 - 推酷](https://img2.tuicool.com/aYJrEr.jpg!web)

[原]最大熵模型中的数学推导 - 推酷

517x337 - 34KB - JPEG

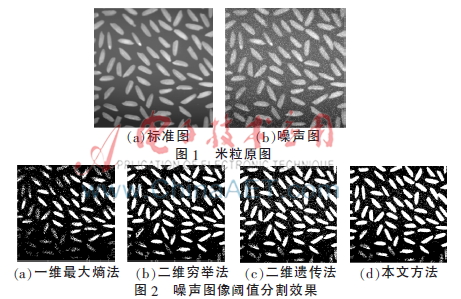

基于改进遗传算法的最佳阈值分割方法及其性能

461x299 - 123KB - JPEG

交叉熵相似性度量在水文时间序列匹配中的应用

800x1098 - 360KB - PNG

交叉熵图像处理.ppt

1280x720 - 113KB - PNG

交叉熵作为分类任务的损失函数,去掉log是否可

842x750 - 69KB - JPEG