交叉熵损失函数(cross entropy loss),下面我们就来理清他们的区别和联系。一般地,一个机器学习模型选择哪种损失函数,是凭借经验而定的,没有什么特定的标准。具体来说, (1)

【摘要】:针对目前数字化研制模式下高可靠、长寿命产品的可靠性评估,提出基于交叉熵(K-L距离)理论的可靠性信息融合评估模型的构造方法,综合利用可靠性仿真结果和可靠性

在matlab中求 img两图像的交叉熵和相对标准差 会员到期时间: 剩余下载个数: 剩余C币: 剩余积分:0 为了良好体验,不建议使用迅雷下载 VIP下载 您今日下载次数已达上限(为了

WGAN理论上给出了GAN训练不稳定的原因,即交叉熵(JS散度)不适合衡量具有不相交部 2.比标准WGAN拥有更快的收敛速度,并能生成更高质量的样本 3.提供稳定的GAN训练方

交叉熵代价函数(Cross-entropy cost function)是用来衡量人工神经网络(ANN)的预测值与实际值的一种方式。与二次代价函数相比,它能更有效地促进ANN的训练。在介绍交叉熵

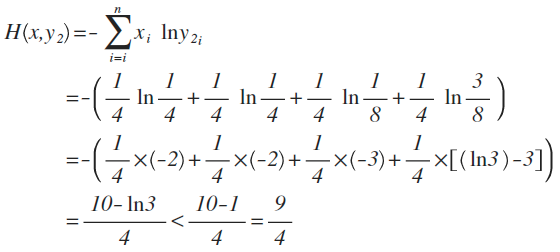

交叉熵(Cross Entropy)是Shannon信息论中一个重要概念,主要用于度量两个概率分布间的差异性信息。语言模型的性能通常用交叉熵和复杂度(perplexity)来衡量。交叉熵的意义

也就是说,距离越大,两个分布差距最大。于是。在我们的模型训练中,我们要做的就是不断的调整参数,使得预测得到的分布与真实分布尽可能的一致。那么,这与交叉熵有什么关

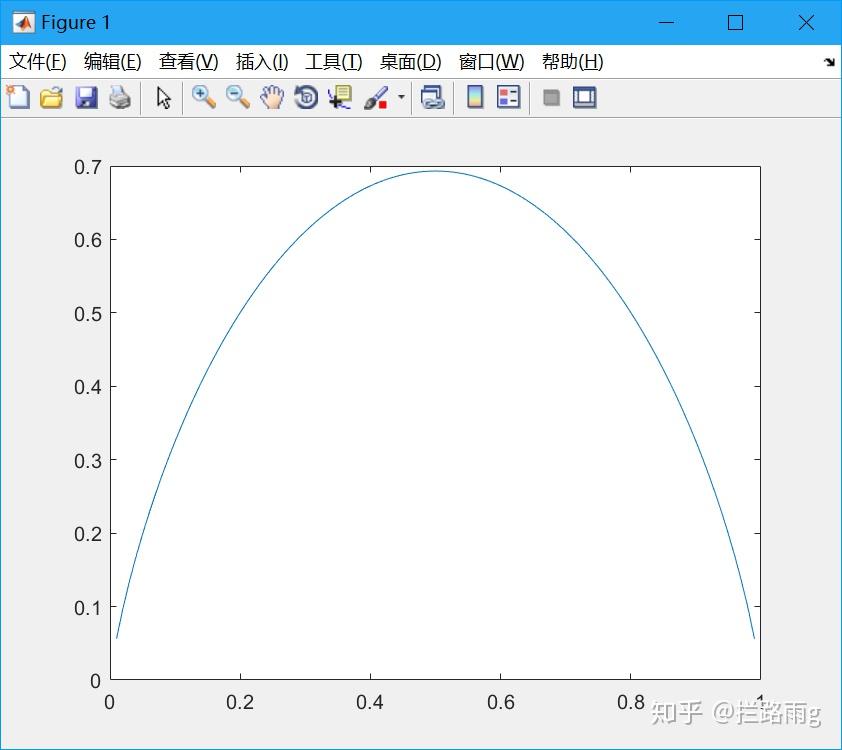

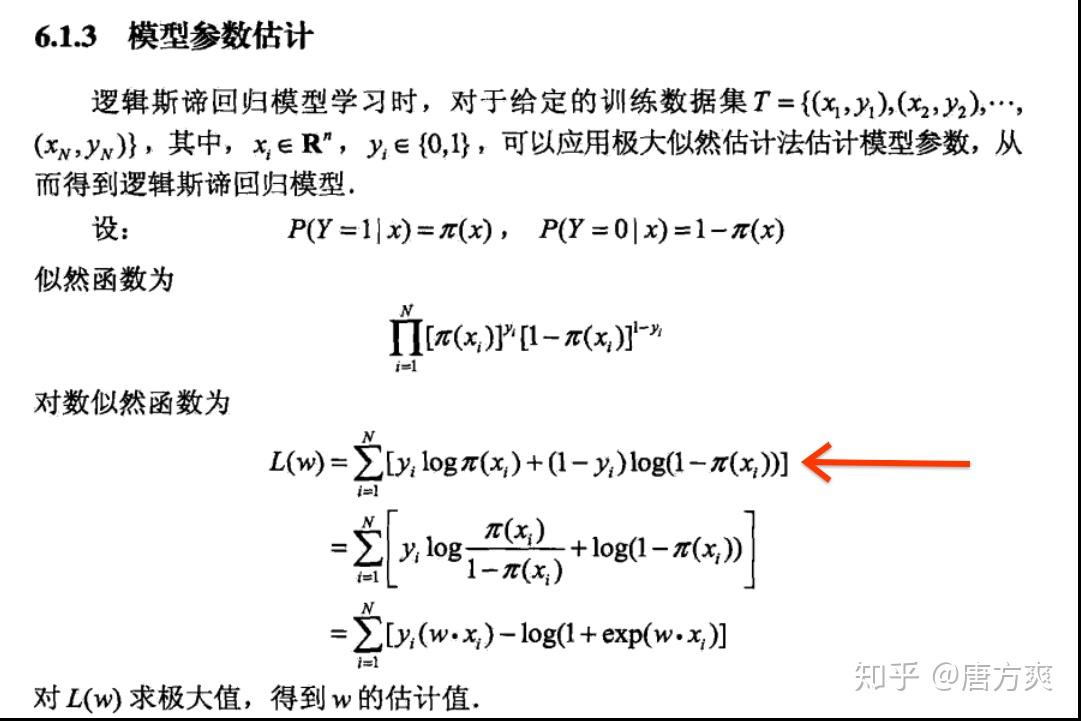

可以看到这就是标准的Cross Entropy算法实现,对W * X得到的值进行sigmoid激活,保证取值在0到1之间,然后放在交叉熵的函数中计算Loss。对于二

另外,交叉熵函数的形式是−[ylna+(1−y)ln(1−a)]而不是 −[alny+(1−a)ln(1−y)],为什么?因为当期望输出的y=0时,lny没有意义;当期望y=1时,ln(1-y)没有意义。而因为a是sigmoid函

而softmax作为分类任务里面重要的一层,所以打算本篇文章介绍一下softmax层。另外,一致沿用的损失函数都是均方误差,所以借这个机会也讲解下当损失函数是交叉熵时候的推

基于交叉熵的出租车资源合理配置.PDF

800x1131 - 278KB - PNG

基于交叉熵的病毒式移动通信系统性能研究-控

800x1131 - 71KB - PNG

交叉熵相似性度量在水文时间序列匹配中的应用

800x1098 - 360KB - PNG

交叉熵图像处理.ppt

1280x720 - 113KB - PNG

基于交叉熵理论的配电变压器寿命组合预测方法

800x1131 - 60KB - PNG

基于量子粒子群优化算法的最小交叉熵多阈值图

800x1217 - 382KB - PNG

交叉熵作为分类任务的损失函数,去掉log是否可

842x750 - 69KB - JPEG

基于交叉熵的正态分布区间数多属性决策方法.

800x1156 - 367KB - PNG

为什么逻辑回归的损失函数叫做交叉熵呢?

1081x721 - 121KB - JPEG

【读懂深度学习中的代价函数、交叉熵】- 一点

469x501 - 33KB - JPEG

归一化(softmax)、信息熵、交叉熵

560x252 - 26KB - PNG

关于神经网络中的代价函数交叉熵的由来

611x211 - 25KB - PNG

简单易懂的softmax交叉熵损失函数求导

640x231 - 8KB - JPEG

基于信息熵的DEA交叉效率综合评价.pdf

800x1098 - 455KB - PNG

理解交叉熵作为损失函数在神经网络中的作用_

578x194 - 20KB - PNG