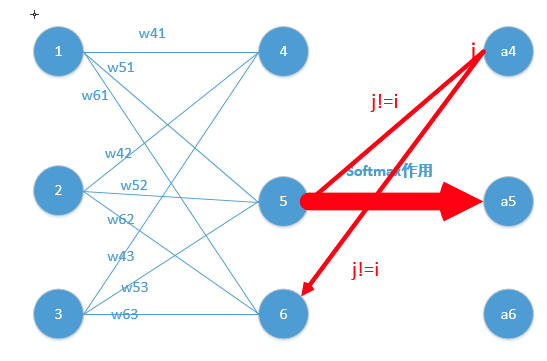

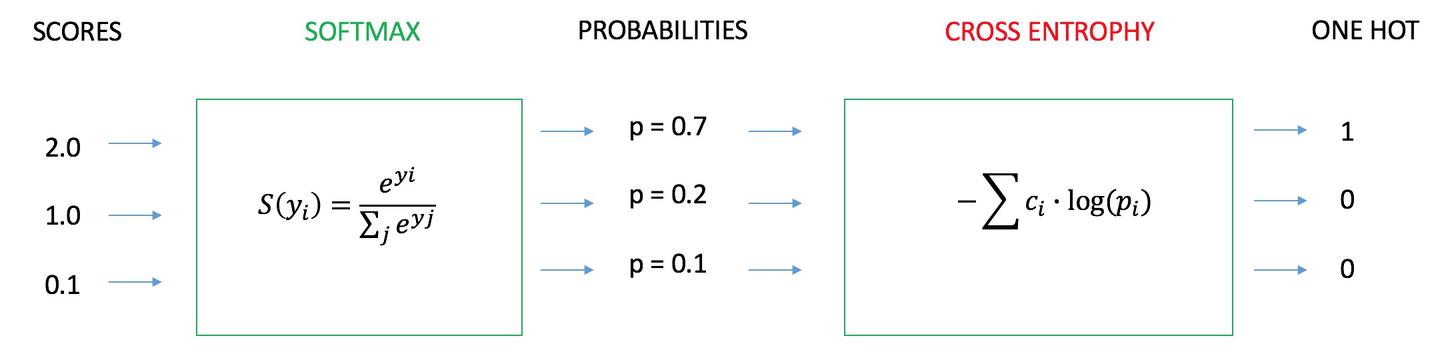

简单易懂的softmax交叉熵损失函数求导 bakaqian 0.2 2017.09.20 22:35* 字数 1057 来写一个softmax求导的推导过程,不仅可以给自己理清思路,还可以造福大众,岂不美哉~ sof

多分类问题的交叉熵的损失函数,求导遇到的问题。具体问题请看图:? 关注者 1 被浏览 1 关注问题写回答 暂时还没有回答,开始写第一个回答

多分类问题的损失函数(交叉熵)求导遇到的问题。具体问题请看图:? 一般的资料上,是假设pi只有一项是1,其余都是0,所以把为0的项都丢掉了,这样当然好求。但是如果不做这个

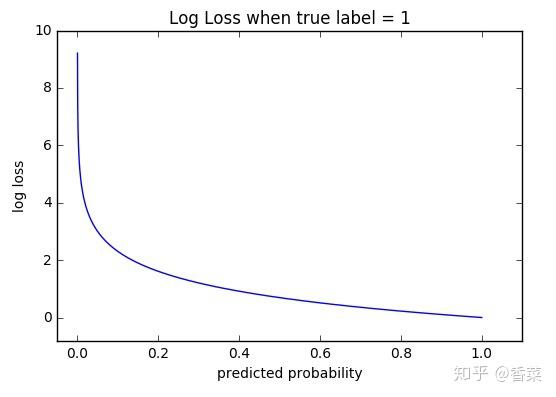

损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵的函数是这样的: C = -\sum

每个Output layer层的输出数据就为 当使用交差熵代价函数的时候 是各个输出点的目标 交叉熵的导数: 对于任意一个输出 Softmax函数的导数: 首先准备一下在计算时会反复用

交叉熵损失函数的求导 这步需要用到一些简单的对数运算公式,这里先以编号形式给出,下面推导过程中使用特意说明时都会在该步骤下脚标标出相应的公式编号,以保证推导的

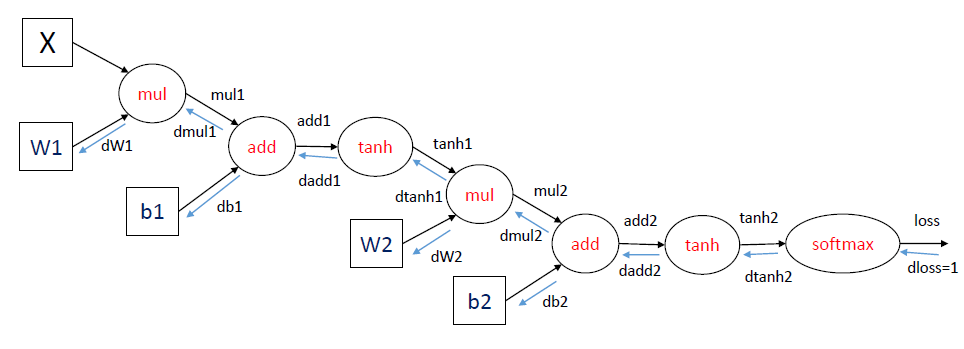

值得一提的是在这里涉及的求导均为矩阵、向量的导数(矩阵微商),这里有一篇 总结得精简又全面,非常棒,推荐给需要的同学。 下面开始推导: 交叉熵损失函数为: J(θ)=−1m∑i

即为交叉熵。举例说明,现有(A,B,C,D)四个字母,其中A出现的概率为1/2,B出现的概率为 2. SE作为分类问题的loss时,由于激活函数求导的影响,造成连续乘以小于1大于0的数(f(

损失函数可以有很多形式,这里用的是交叉熵函数,主要是由于这个求导结果比较简单,易于计算,并且交叉熵解决某些损失函数学习缓慢的问题。交叉熵

交 叉 熵 损 失 函 数 chyang1999|2018-06-30 (高于99%的文档) 马上扫一扫 手机打开 随 函数作为神经元的激活函数时,最好使用交叉熵代价函数来替 代方差代价函数,以避免训

简单易懂的softmax交叉熵损失函数求导

640x231 - 8KB - JPEG

简单易懂的softmax交叉熵损失函数求导

640x475 - 29KB - JPEG

Softmax 函数的特点和作用是什么?

547x361 - 43KB - PNG

简单易懂的softmax交叉熵损失函数求导

640x475 - 47KB - JPEG

损失函数--交叉熵损失函数

556x397 - 22KB - JPEG

关于神经网络中的代价函数交叉熵的由来

611x211 - 25KB - PNG

为什么逻辑回归中要使用交叉熵损失函数?

453x181 - 8KB - JPEG

为什么逻辑回归中要使用交叉熵损失函数?

222x119 - 2KB - JPEG

交叉熵代价函数

312x119 - 25KB - JPEG

如何直观的解释back propagation算法? - 龚禹的

964x349 - 25KB - PNG

TensorFlow:最棒的深度学习加速器_海内网

485x352 - 51KB - PNG

TensorFlow:最棒的深度学习加速器_科技频道_

485x351 - 11KB - JPEG

损失函数--交叉熵损失函数

1200x500 - 48KB - JPEG

交叉熵损失函数

588x260 - 29KB - PNG

交叉熵损失函数

678x260 - 47KB - PNG