网络爬虫框架Scrapy详解之Request

640x307 - 65KB - JPEG

Python爬虫框架之Scrapy详解

622x440 - 36KB - JPEG

网络爬虫框架Scrapy详解之Request

584x421 - 21KB - JPEG

网络爬虫框架Scrapy详解之Request

433x182 - 24KB - JPEG

python scrapy的一点杂谈 - Python开发技术文章

831x544 - 19KB - JPEG

Python:Scrapy爬取小说

640x560 - 44KB - JPEG

在Linux系统上安装Python的Scrapy框架的教程

293x386 - 21KB - PNG

Python爬虫实战:Scrapy豆瓣电影爬取

550x227 - 60KB - PNG

Scrapy: 10分钟写一个爬虫抓取美女图

640x319 - 11KB - JPEG

Scrapy网络爬虫框架实际案例讲解,Python爬虫

621x388 - 33KB - JPEG

Scrapy网络爬虫框架实际案例讲解,Python爬虫

440x325 - 28KB - JPEG

Centos7 Python3下安装scrapy的详细步骤

700x435 - 71KB - PNG

Python_1024

300x240 - 57KB - PNG

零基础开始学习Python爬虫(scrapy)一

640x420 - 22KB - JPEG

Scrapy中的scrapy.Spider.parse()如何被调用?

1120x805 - 51KB - PNG

scrapy版本:1.1.2 请问如何设置只要没有成功的返回response则把任务重新放进Request队列中去继续爬取?

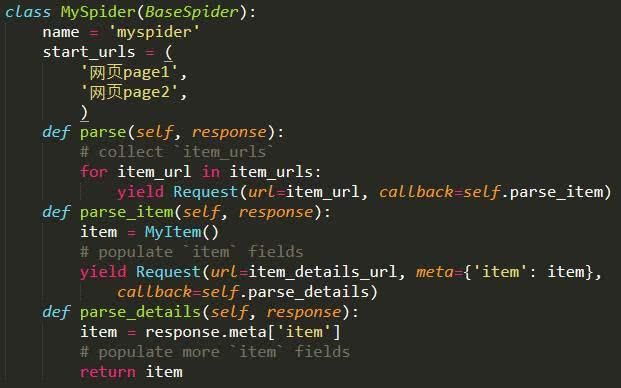

def parse_page1(self,response):item=MyItem()item['main_url']=response.url request=scrapy.Request(

def start_requests(self):for u in self.start_urls:yield scrapy.Request(u,callback=self.parse_httpbin

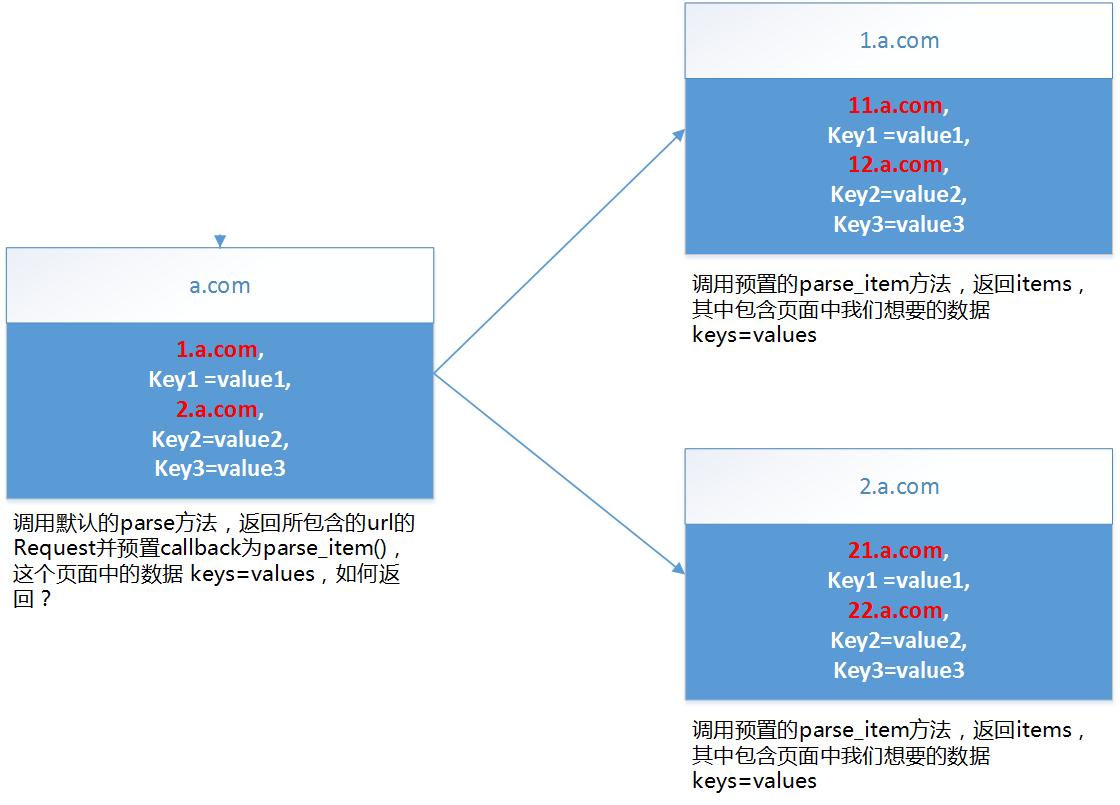

scrapy 在不同的抓取级别的Request之间传递参数的办法,下面的范例中,parse_item通过meat传递给了parse_

一个用户完整的信息要在多个Scrapy采用的是回调(callback)的方式,把请求处理交给下一次请求,在请求时用

result_list.append(scrapy.Request(url,callback=self.parse))return result_list 区别在于用了yield的

介绍Scrapy框架的request对象和response对象 通常,Request对象在爬虫程序中生成并传递到系统,直到它们

first()yield=scrapy.Request(url=url,meta={ 'item':item} callback=self.parse2)''' 比如我们要爬取淘宝

yield Request(url,meta={ 'item':item,'itemB':itemB,'itemC':itemBC },callback=self.parse) 取出多个