ceph rbd快照原理解析

835x601 - 17KB - PNG

ceph rbd快照原理解析

300x215 - 13KB - JPEG

openstack nova后端使用ceph rbd(增加在线迁移

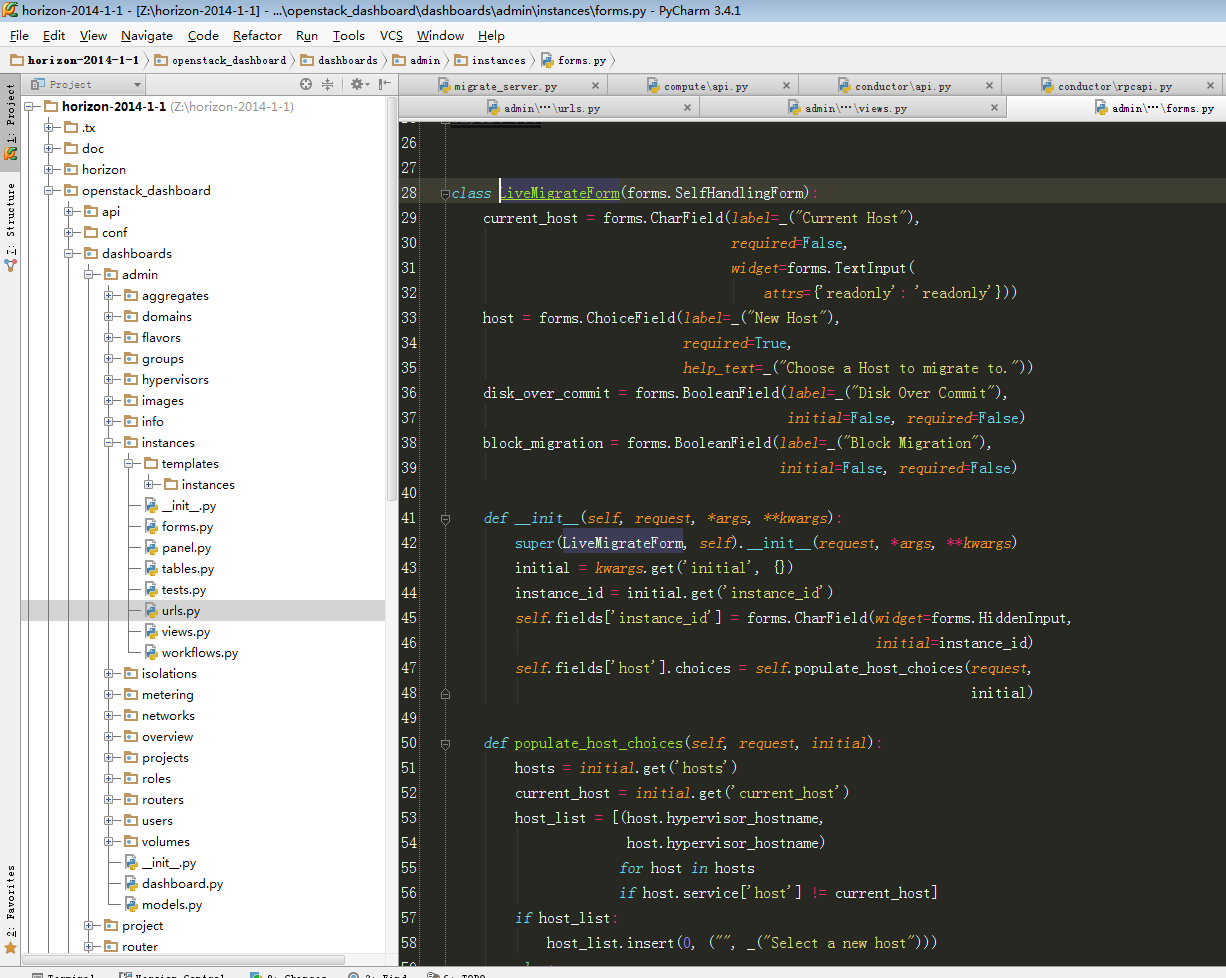

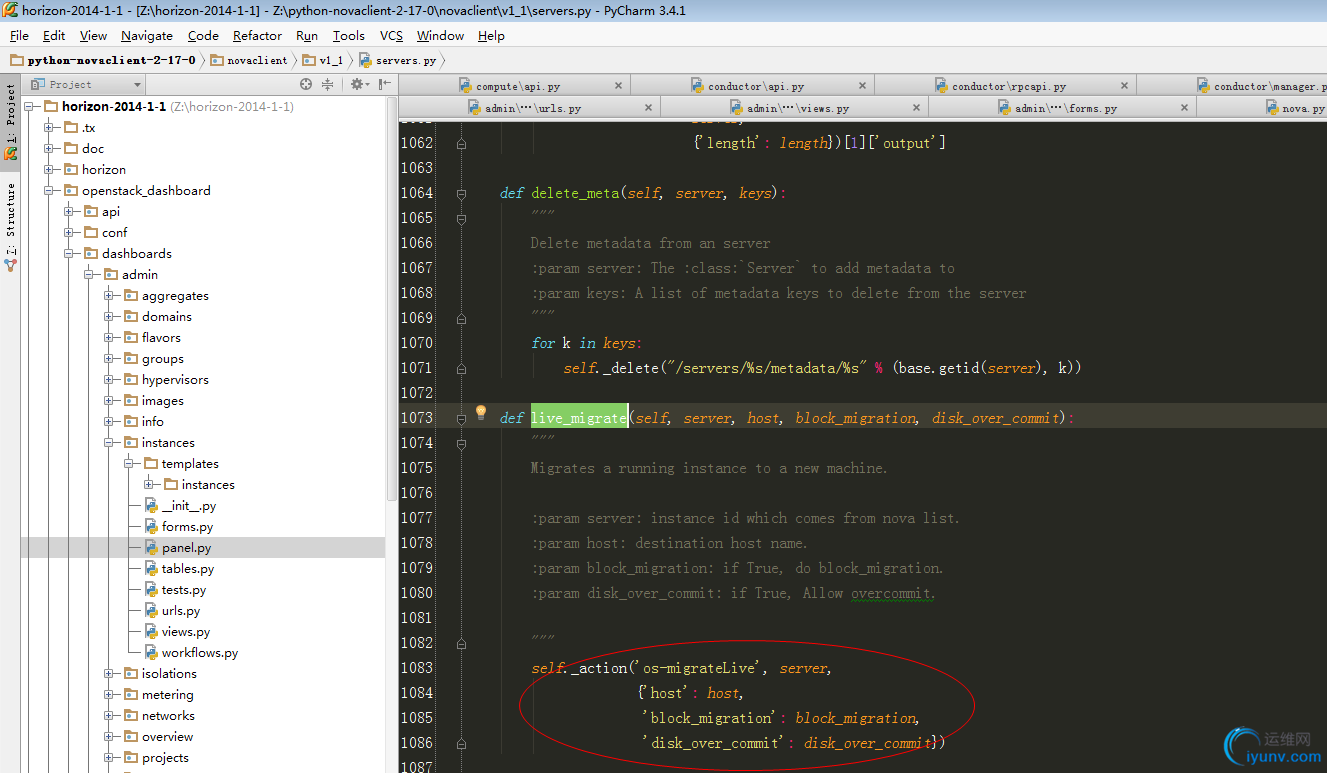

1226x978 - 106KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

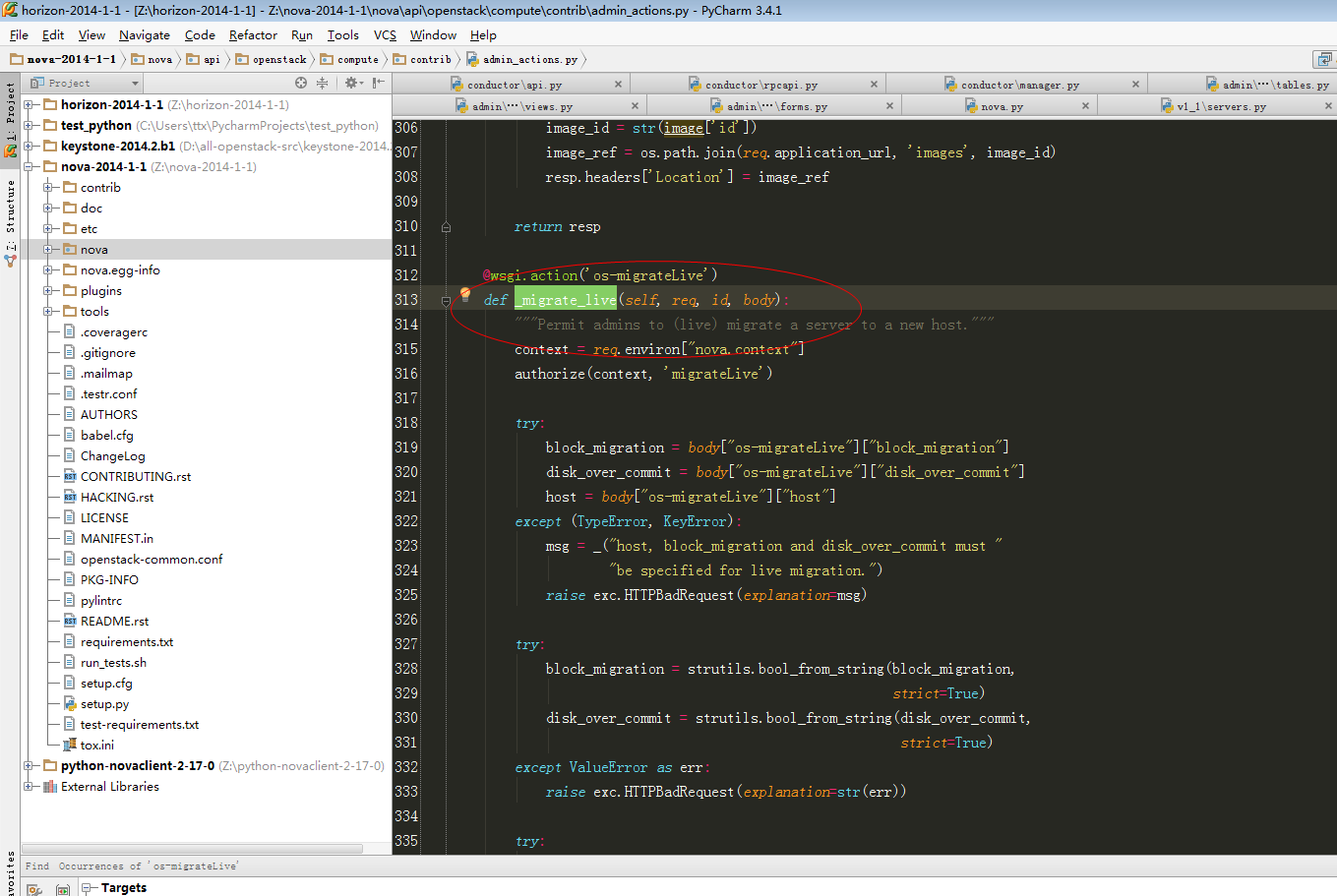

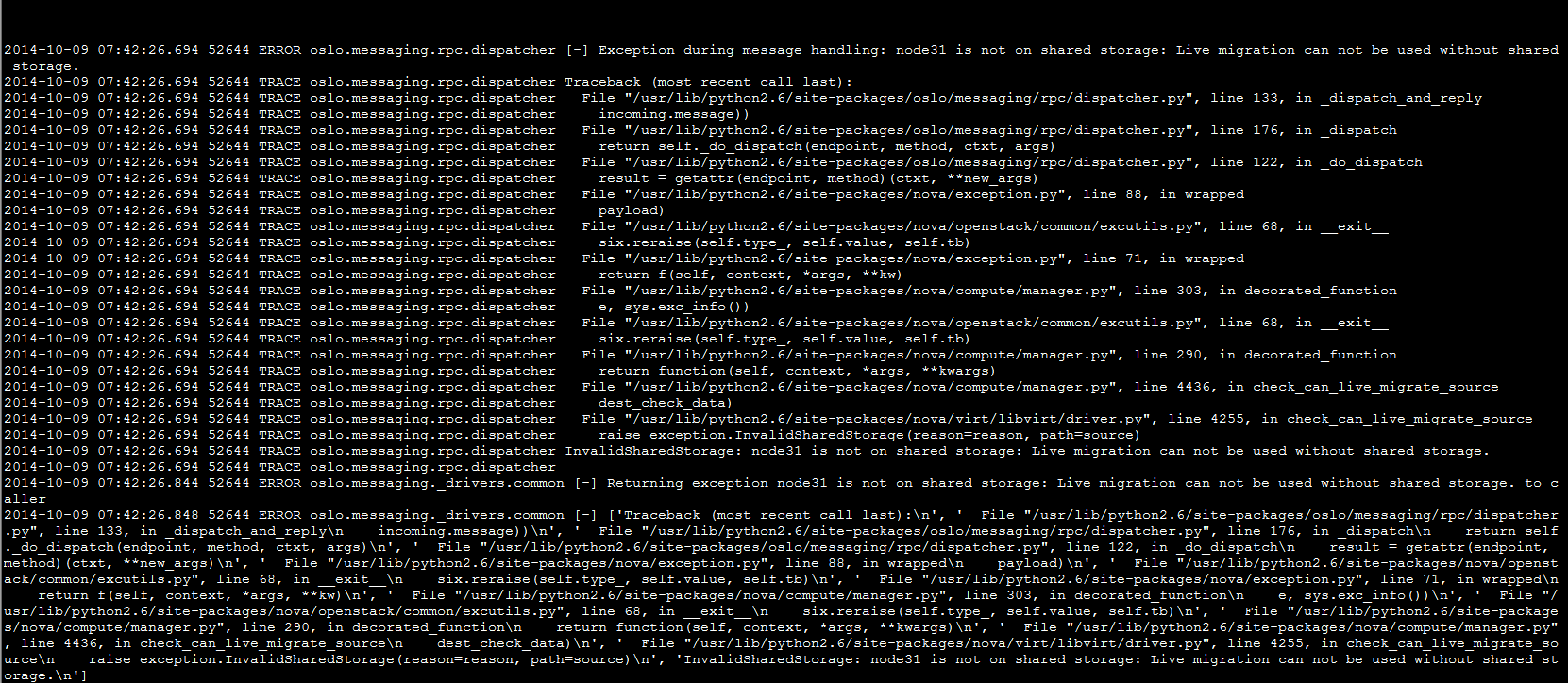

1359x911 - 98KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

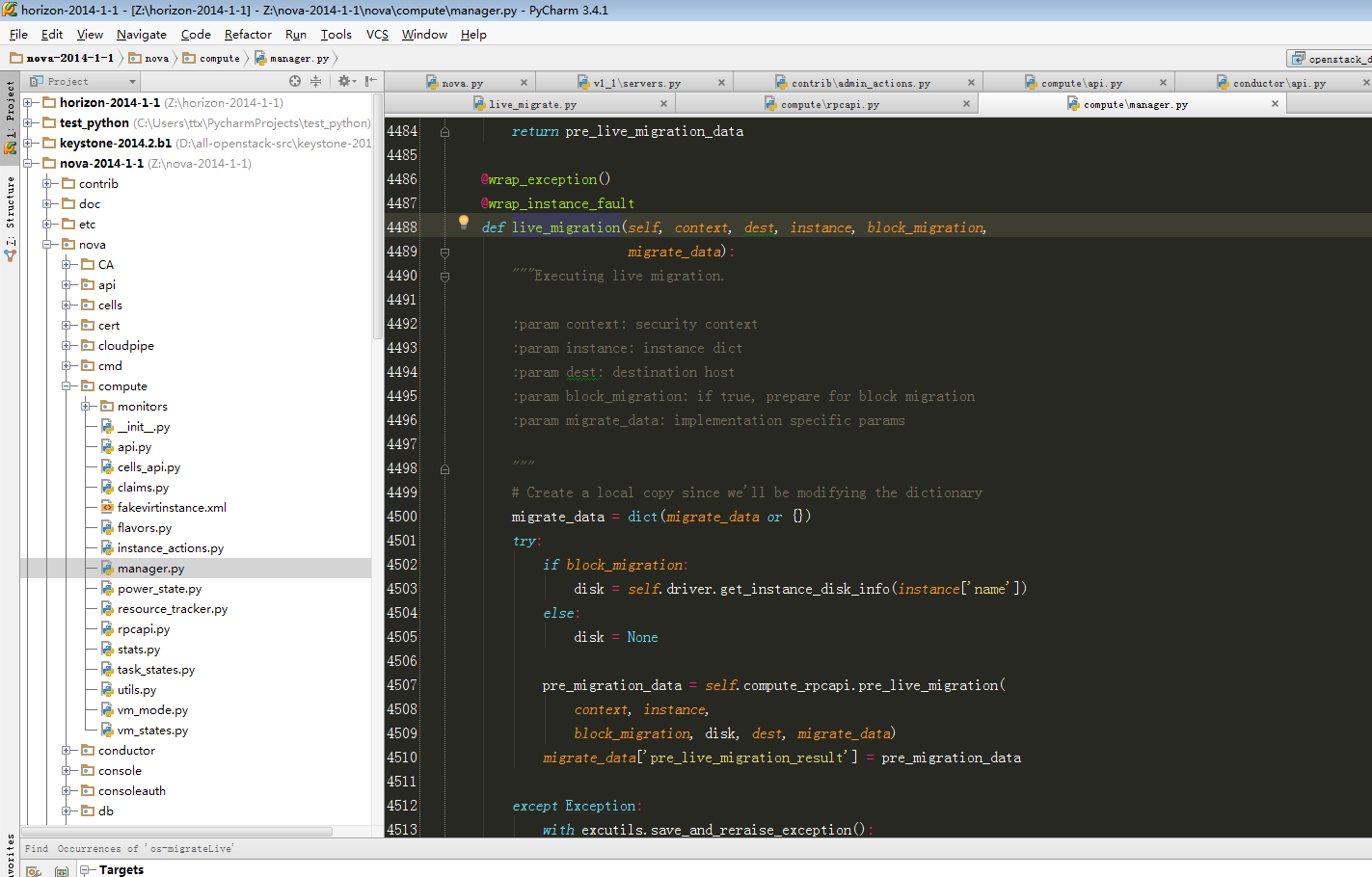

1425x897 - 97KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

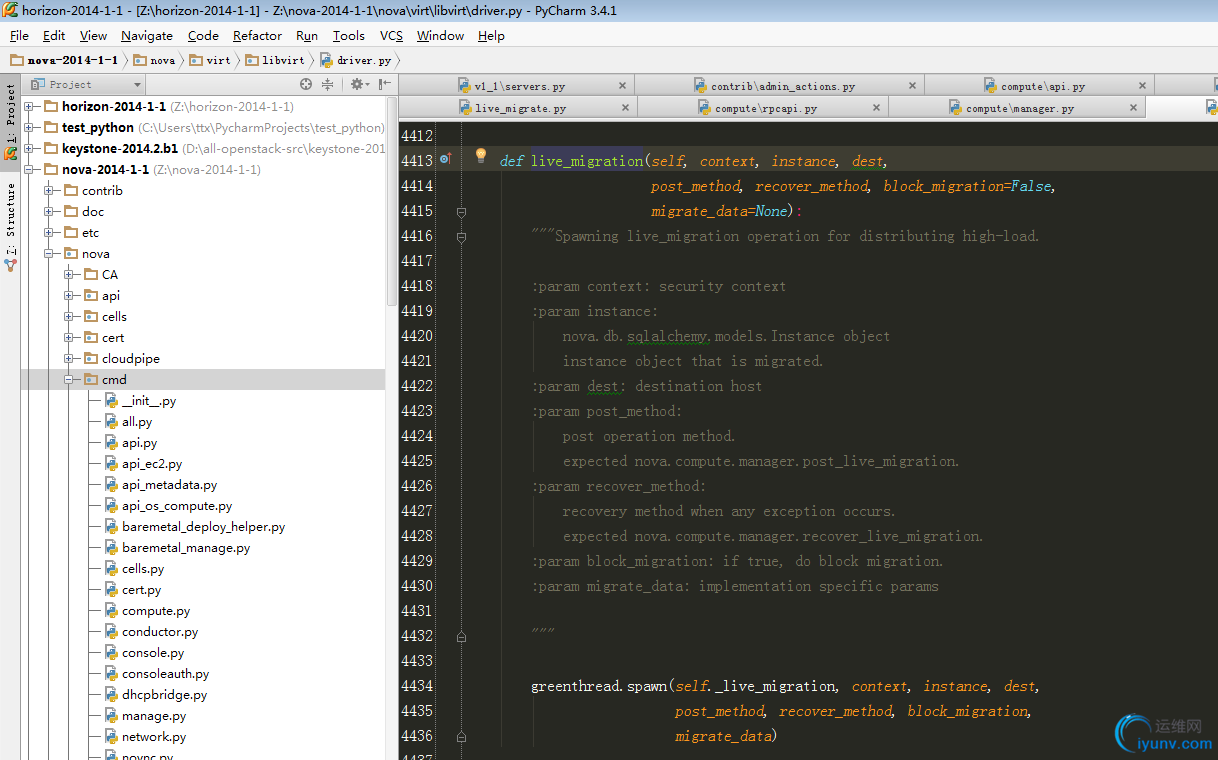

1423x910 - 100KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

1284x853 - 96KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

1431x814 - 101KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

962x869 - 32KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

819x810 - 85KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

1218x760 - 122KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

1327x773 - 125KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

1661x724 - 137KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

1358x829 - 135KB - PNG

openstack nova后端使用ceph rbd(增加在线迁移

1659x680 - 53KB - PNG

基于Ceph RBD的快照技术,通过差量文 件的方式定期将数据备份到灾备中心,当主数据中心发生故障时,从灾备

KVM+ceph-RBD 快照创建问题 环境描述ceph集群,Luminous 12.2.5版本;执行操作1.划分存储池cloud,指定存储

前段时间一直在研究ceph的快照以及其所涉及的故障恢复逻辑,ceph在这部分的实现挺精妙1.rbd快照的直观理解

ceph osd pool create testrbd 128snap_clone 2048 M 2 解除了rbd快照的父子关系 5.4 RBD 导入和导出(用于

http://www.sysnote.org/2016/02/28/ceph-rbd-snap/前段时间一直在研究ceph的快照以及其所涉及的故障恢复

Ceph支持一个非常好的特性,以COW(写时复制)的方式从RBD快照创建克隆,分层特性允许用户创建多个CEPH RBD

基本原理 整体概念:官方文档:CEPH BLOCK DEVICErbd总体架构和原理:《ceph设计原理与实现》第六章rbd快照

《Ceph Cookbook 中文版》从认识块、对象和文件存储开始,到与OpenStack 的本节为大家介绍使用RBD 快照。

这个问题是不久前在ceph社区群里可以看到做了存储池快照的存储池无法创建image了,并且提示了没有配置成