Scrapy-redis爬虫分布式爬取的分析和实现_「

480x311 - 17KB - JPEG

scrapy-redis分布式爬虫启动为什么会等待

600x381 - 19KB - JPEG

使用scrapy-redis框架实现分布式爬虫(1)!

1174x725 - 198KB - PNG

使用scrapy,redis, mongodb实现的一个分布式网

1121x517 - 246KB - PNG

python--scrapy-redis分布式组件 - 想54256 - 博

1534x1010 - 572KB - PNG

使用scrapy,redis,mongodb实现的一个分布式网

500x268 - 66KB - JPEG

scrapy-redis使用详解_NoSQL_第七城市

830x455 - 448KB - PNG

基于Redis的三种分布式爬虫策略_「电脑玩物

911x463 - 48KB - PNG

使用scrapy-redis框架实现分布式爬虫(1)!

326x245 - 21KB - JPEG

scrapy_redis实现爬虫

1035x790 - 375KB - PNG

scrapy-redis使用详解_NoSQL_第七城市

486x218 - 48KB - JPEG

怎么样实现scrapy_redis爬虫分布式爬取功能?

490x346 - 51KB - PNG

第9章 scrapy-redis分布式爬虫_Python_第七城

809x519 - 28KB - PNG

第9章 scrapy-redis分布式爬虫_Python_第七城

1023x401 - 40KB - PNG

使用scrapy,redis,mongodb实现的一个分布式网

500x230 - 88KB - JPEG

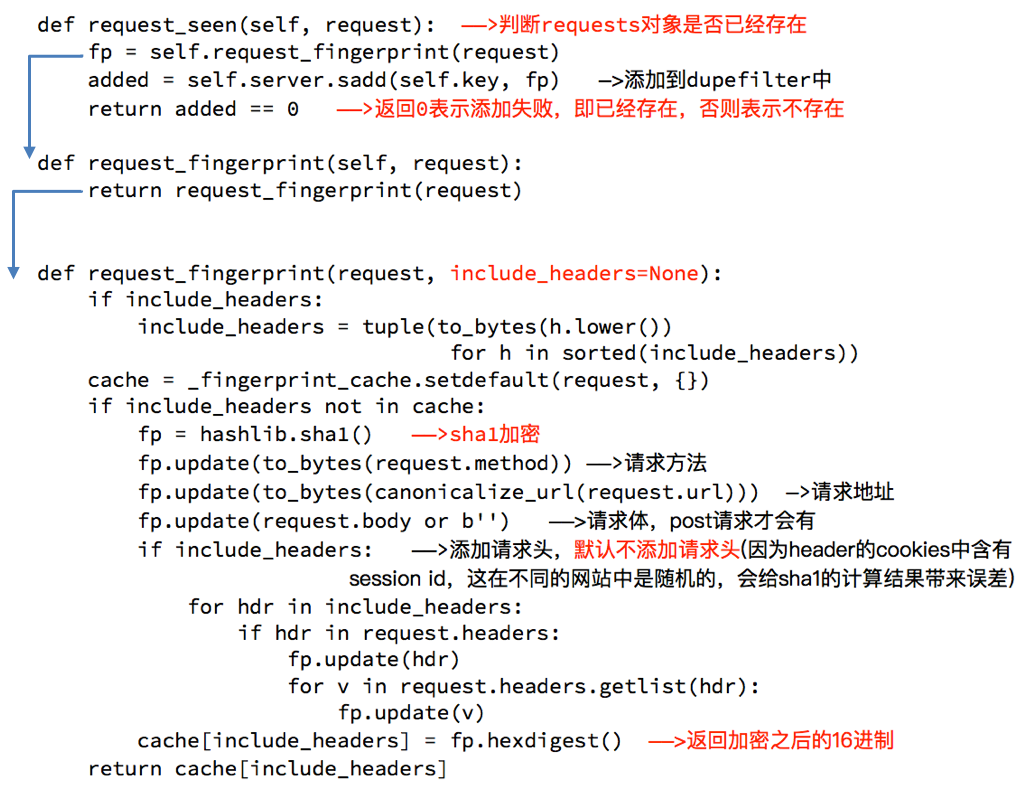

不使用scrapy默认的去重方式 DUPEFILTER_CLASS="scrapy_redis.dupefilter.RFPDupeFilter"#使用scrapy-redis

目标任务:将之前新浪网的Scrapy爬虫项目,修改为基于RedisSpider类的scrapy-redis分布式爬虫项目,将数据

SCHEDULER="scrapy_redis.scheduler.Scheduler"SCHEDULER_PERSIST=True SCHEDULER_QUEUE_CLASS='scrapy_

安装scrapy: 回到脚本文件中,将定义的items引入文件,并创建一个items实例,将对应的数据填充进去,然后

技术工具:Python3.5 scrapy scrapy_redis redis docker1.12 docker-compose Kitematic mysql SQLAlchemy

根据源代码来看,scrapy-redis使用了scrapy本身的一个fingerprint接所以分布式运行时会有一个spider的

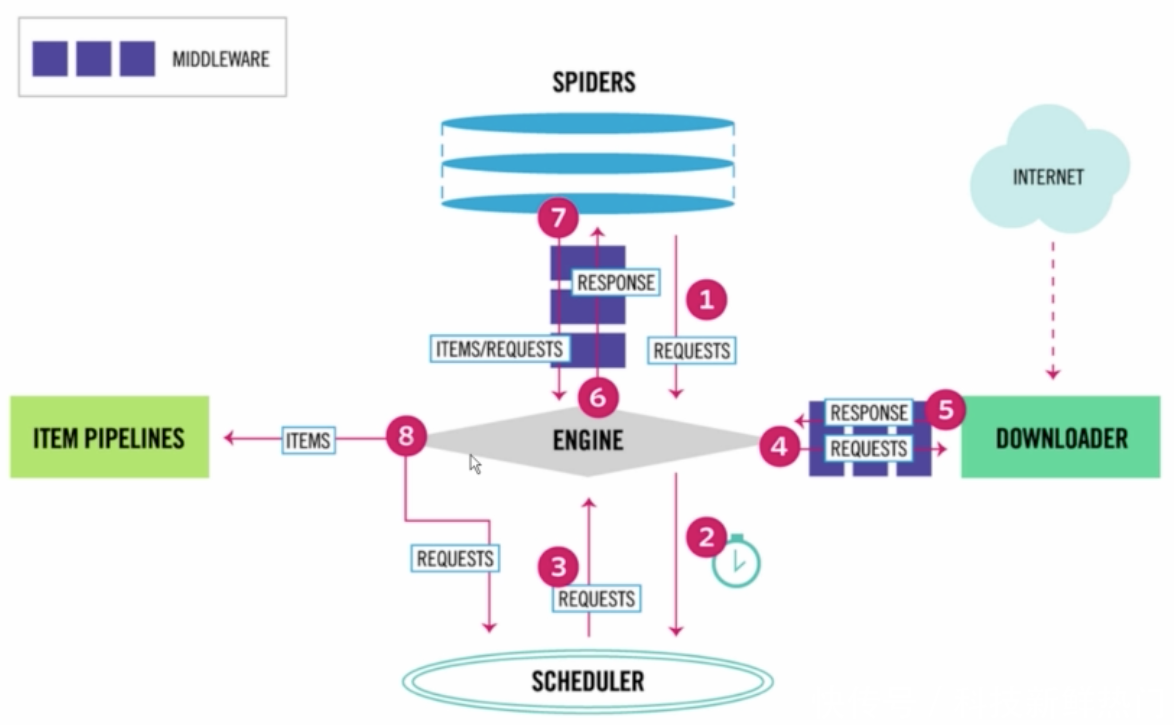

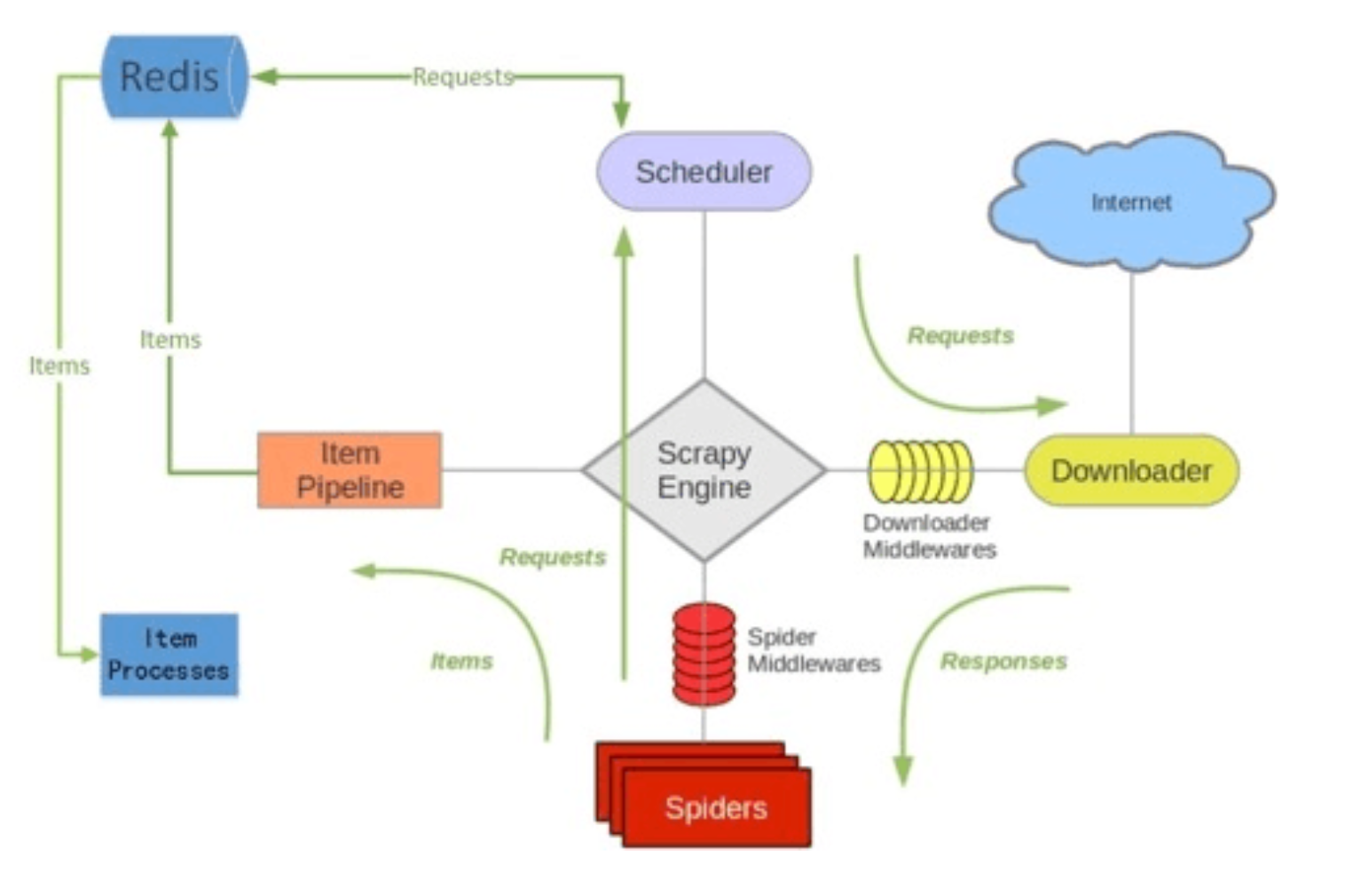

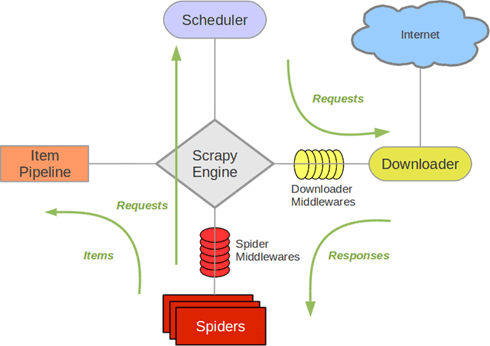

所谓的scrapy-Redis实际上就是scrapy+redis,其中对redis的操作采用redis-py客户端。下面这篇文章详细介绍

推荐使用anaconda、不然还是老老实实用Linux吧 安装Scrapy-Redis 需要注意:Python 版本为 2.7,3.4 或者3.

在上篇 使用Scrapy爬取知乎用户信息 我们编写了一个单机的爬虫,这篇记录了使用 Scrapy-Redis 将其重写,使

pip install scrapy-redis easy_install scrapy-redis stable 3.0.2 运行redis redis-server redis.conf