HBase结合MapReduce批量导入 - 综合编程类

894x341 - 39KB - PNG

Spark上通过BulkLoad快速将海量数据导入到H

935x392 - 68KB - PNG

使用Sqoop从MySQL导入数据到Hive和HBase

638x251 - 20KB - PNG

HBase导入大数据三大方式之(一)hive类SQL语

723x500 - 181KB - JPEG

MapReduce将HDFS文本数据导入HBase中 - 推

550x426 - 152KB - PNG

Sqoop将mysql数据导入hbase的血与泪 - 北京尚

925x340 - 31KB - PNG

Sqoop将mysql数据导入hbase的血与泪 - 北京尚

1707x654 - 840KB - PNG

apach hadoop2.6 集群利用Phoenix 4.6-hbase

845x373 - 23KB - PNG

HBase(三): Azure HDInsigt HBase表数据导入本

507x545 - 31KB - PNG

使用Mapreduce将hbase表中的数据全量导入E

820x633 - 60KB - JPEG

HBase(三): Azure HDInsigt HBase表数据导入本

730x394 - 40KB - PNG

HBase(三): Azure HDInsigt HBase表数据导入本

667x391 - 40KB - PNG

HBase(三): Azure HDInsigt HBase表数据导入本

659x297 - 26KB - PNG

apach hadoop2.6 集群利用Phoenix 4.6-hbase

679x270 - 21KB - PNG

Nginx日志导入到Hive0.13.1,同步Hbase0.96.2,

550x301 - 111KB - PNG

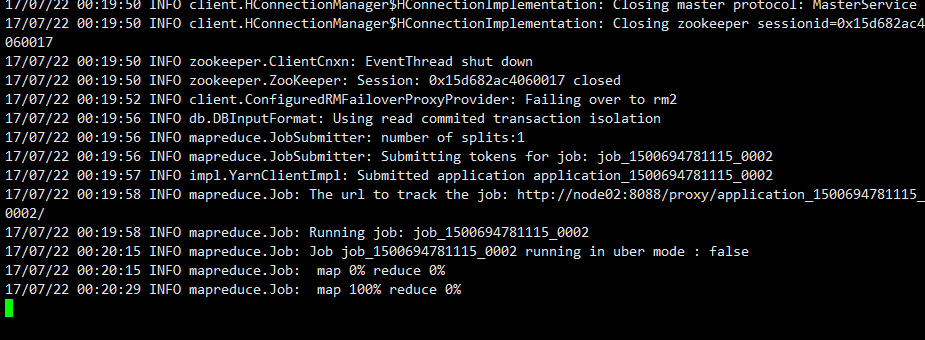

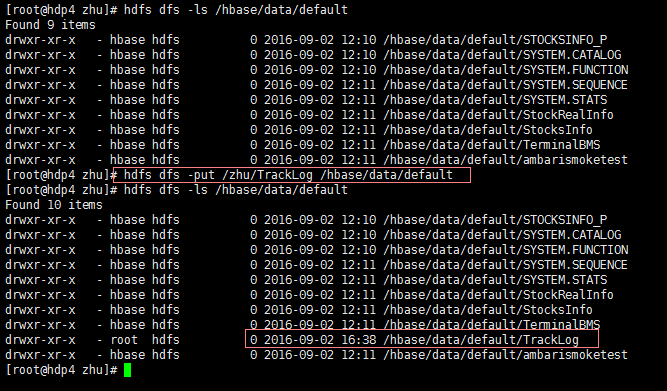

Sqoop 将mysql数据导入hbase的血与泪(整整搞了大半天) column-family cf-hbase-row-key id-where"id>=5"-

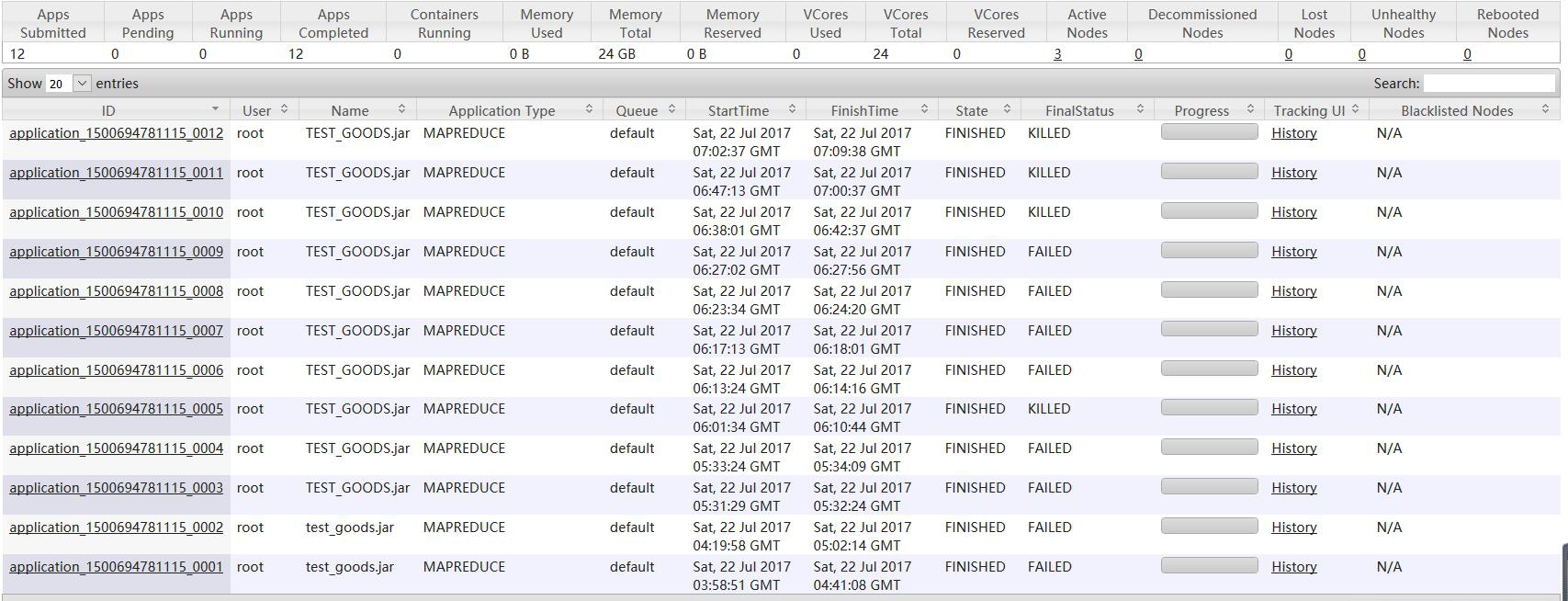

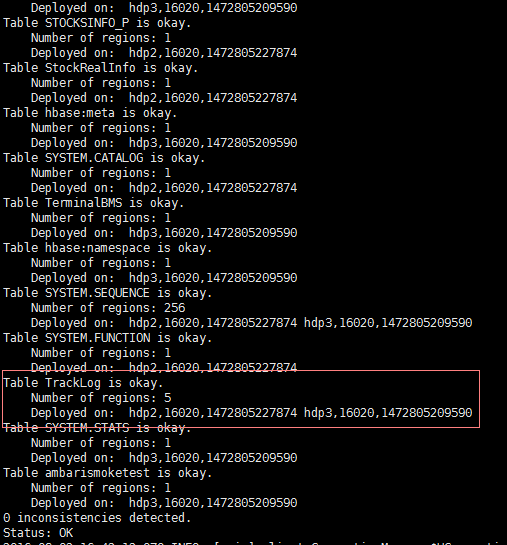

要使用Hadoop,需要将现有的各种类型的数据库或数据文件中的数据导入HBase。一般而言,有三种常见方式:

最近有个需求要对mysql的全量数据迁移到hbase,虽然hbase的设计非常利于高效就会显示刚才导入的offer表了。

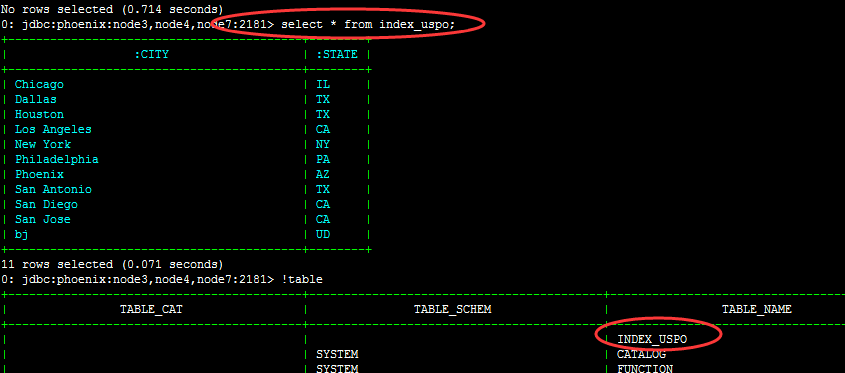

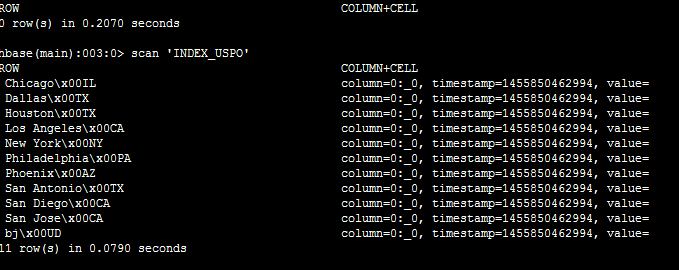

摘要:Hive如何加载和导入HBase的数据 注意:在插入数据的时候一定要指定column(如id:val,name:val)直接使用

如果加-hbase-row-key ID同理也是不行滴,因此,针对我要导入的test表只能暂时用-hbase-row-key STATE了。

Alex 的 Hadoop 菜鸟教程:第13课 Sqoop1 导入 Hbase 以及 Hive 承接上节课,继续讲如何使用sqoop将mysql的

尽管importtsv 工具在需要将文本数据导入HBase的时候十分有用,但是有一些情况,比如导入其他格式的数据,

难道没有把HBase里面的数据直接导入到Hive当中的工具或者方法吗?hbase shell create 'student','id','name

Put API可能是将数据快速导入HBase表的最直接的方法。但是在导入【大量数据】时不建议使用!但是可以作为