scrapy redis去重失败_众安重疾保险理赔失败

scrapy 实现去重,存入redis(增量爬取)

678x260 - 16KB - JPEG

scrapy 实现去重,存入redis(增量爬取)

300x260 - 9KB - JPEG

Scrapy利用Redis实现消重存入MySQL(增量爬

600x260 - 27KB - JPEG

Scrapy利用Redis实现消重存入MySQL(增量爬

678x260 - 98KB - PNG

Scrapy利用Redis实现消重存入MySQL(增量爬

322x260 - 31KB - JPEG

基于Redis的三种分布式爬虫策略_「电脑玩物

1068x478 - 43KB - PNG

scrapy进行分布式爬虫

424x168 - 14KB - PNG

Python分布式爬虫打造搜索引擎

995x449 - 285KB - PNG

有网友碰到过这样的scrapy 加入redis去重之后出现了如下报错,为什么,问题scrapy-redis爬取失败怎么处理

大家应该知道scrapy是默认开启了去重的,用了scrapy_redis后去重队列放在redis里面。我接手过来的时候爬虫

新增一个节点D,redis cluster的这种做法是从各个节点的前面各拿取一部分slot到D上,我会在接下来的实践中

将redis set集合 改为zset 且score为时间戳 key值修改scrapy-redis下的去重文件dupefilter.py修改文件下的

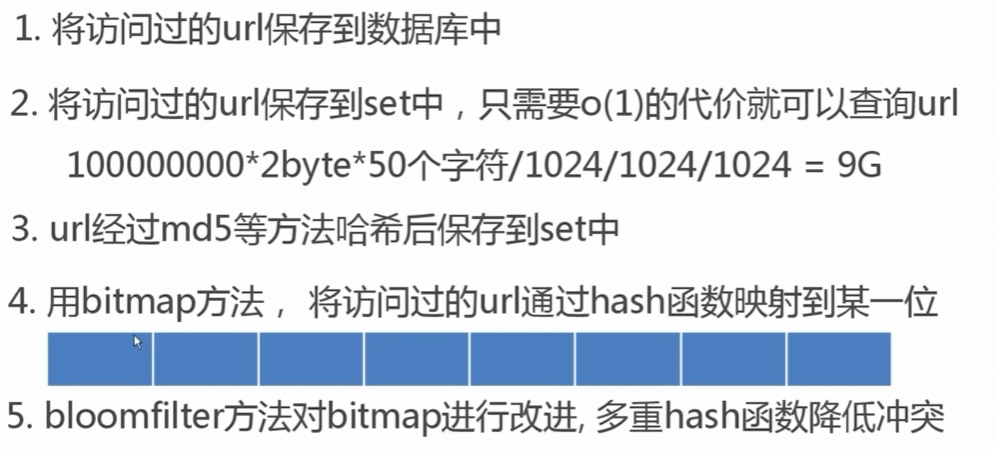

使用BloomFilter优化scrapy-redis去重 1.背景 做爬虫的都知道,scrapy是一个非常好用的爬虫框架,但是

使用scrapy-redis后,过滤重复的request不能使用原来scrapy的过去组件,要scrapy-redis的,在settings.py上

确保所有的爬虫通过Redis去重#DUPEFILTER_CLASS="scrapy_redis.dupefilter.RFPDupeFilter"DUPEFILTER_CLASS

最开始的想法是指用redis的set实现url去重,但在后面开发中无意的解决了import redis import time from

好郁闷啊,把内存清了重新爬么,怎么去重重复的。显示全部 数据量小时,就用框架的request_fingerprint;

关于redis的代码 settings.py下 去重代码 显示全部 使用scrapy-redis后,过滤重复的request不能使用原来